引言

随着人工智能技术的迅猛发展写作已经成为了一个备受关注的话题。写作是指利用人工智能技术自动生成文本内容的过程包含但不限于新闻报道、小说创作、诗歌写作等。这一技术不仅可以增强内容生产效率还能为人类提供更加多样化和个性化的信息。写作的核心在于通过深度学习算法和语言模型使机器可以理解并生成自然语言。近年来随着神经网络技术的进步写作的效果已经越来越接近甚至在某些方面超越了人类的水平。写作也面临着诸多挑战,如怎样保证生成内容的准确性和原创性,以及怎样应对版权和伦理难题等。本文将深入探讨写作的原理、算法和模型,并对其未来发展实行展望。

写作是什么意思?

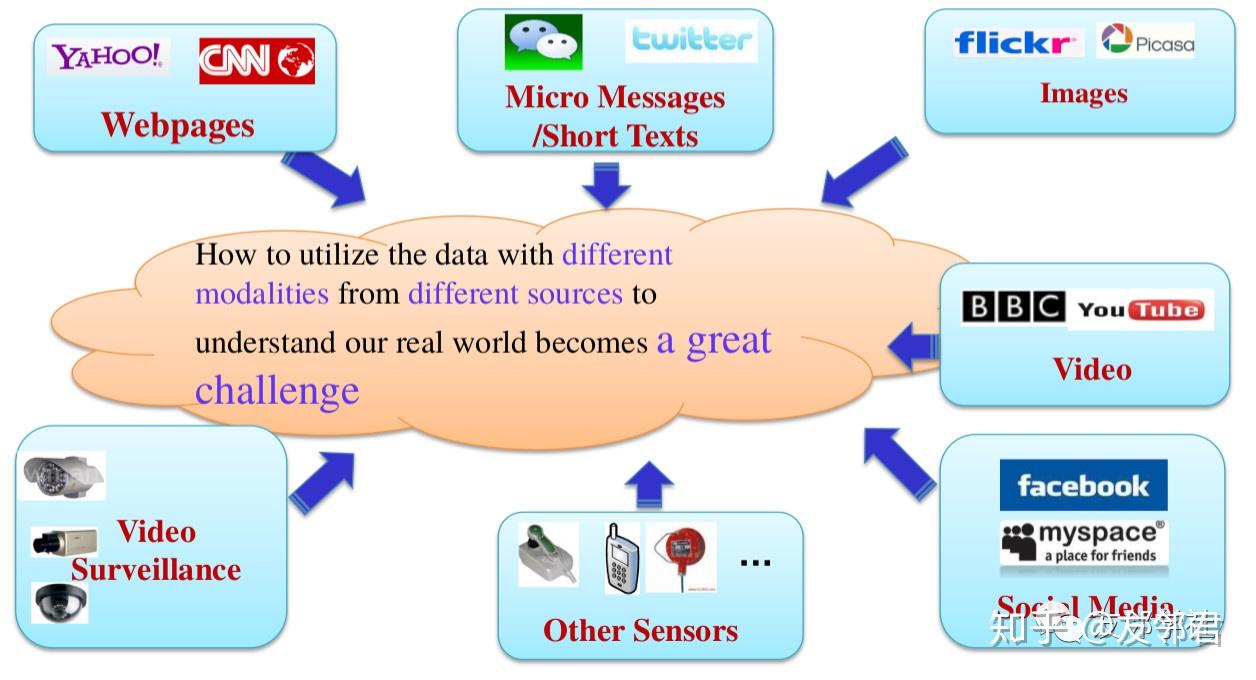

写作是指通过计算机程序自动产生文本内容的过程。此类程序多数情况下基于机器学习和深度学习技术可模仿人类的写作过程,生成各种类型的文本,从简单的新闻报道到复杂的文学作品。写作的应用范围非常广泛,不仅可用于新闻媒体行业,还能够用于社交媒体、广告、教育等领域。例如,若干新闻网站已经开始利用写作工具来生成体育新闻、财经报告等。写作还可用于自动化报告生成、市场分析报告等场景,极大地提升了工作效率。

写作原理

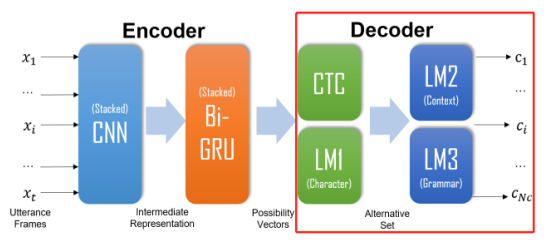

写作的基本原理是通过机器学习算法对大量文本数据实行训练,从而让机器学会理解和生成自然语言。这一过程往往分为两个主要步骤:数据准备和模型训练。需要收集大量的文本数据作为训练集,这些数据能够来自互联网、书籍、报纸等各种来源。接着通过算法对这些数据实施预解决,如分词、去除停用词等以便于机器更好地理解和学习。 利用深度学习技术,如循环神经网络(RNN)、长短时记忆网络(LSTM)和变压器模型(Transformer),对预应对后的数据实施训练。这些模型通过学习输入文本的模式和结构,逐步掌握语言的规律和特点从而能够在新的输入下生成合理的文本。

写作算法

写作中常用的算法主要包含循环神经网络(RNN)、长短时记忆网络(LSTM)和变压器模型(Transformer)。其中,RNN是一种能够应对序列数据的神经网络,它通过时间步的办法逐个应对输入序列中的元素,并在每个时间步中保留之前的信息。LSTM是一种特殊的RNN它可解决传统RNN在长序列中容易出现的梯度消失或爆炸的疑问。而Transformer则是一种基于关注力机制的模型,它通过自留意力机制来捕捉输入序列中的长期依赖关系,大大增进了模型的效率和性能。这些算法各有优缺点,但在实际应用中往往会依据具体任务的需求实行选择和优化。

写作模型

写作中最常用的语言模型有GPT(Generative Pre-trned Transformer)系列和BERT(Bidirectional Encoder Representations from Transformers)系列。GPT系列模型主要用于文本生成任务,如新闻报道、小说创作等。它们通过在大规模语料库上实施预训练学会了语言的上下文关系和语义结构,从而能够在给定提示的情况下生成连贯且富有创意的文本。而BERT系列模型主要用于文本理解任务,如情感分析、问答系统等。它们通过双向编码器结构,能够同时考虑一个词在上下文中的前后信息,从而加强了模型的理解能力。这些模型的不断迭代和优化,使得写作的效果越来越接近甚至超越人类的水平。

未来展望

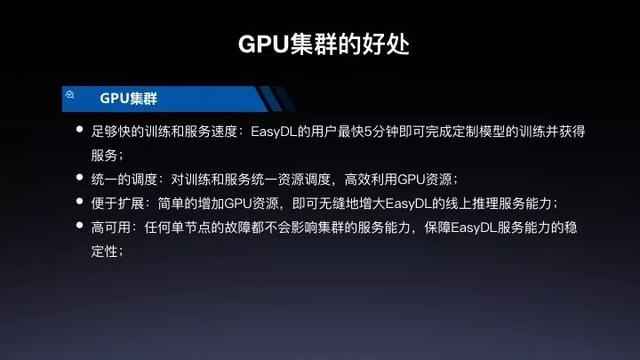

随着写作技术的不断发展,其应用场景将会越来越广泛。未来的写作可能将会更加注重个性化和交互性,为使用者提供更加丰富和多样化的体验。例如通过结合虚拟现实技术,使用者可在沉浸式环境中实行创作;通过增强现实技术,客户能够在真实世界中看到由生成的文本内容。随着大数据和云计算的发展,写作将会更加高效和智能,能够快速应对海量的数据并生成高优劣的文本。同时写作也将面临更多的挑战,如怎样确信生成内容的准确性和真实性,怎样解决版权和伦理疑惑等。这些疑问需要咱们在技术进步的同时不断探索和创新,以推动写作技术的健康发展。