引语

随着人工智能技术的快速发展,自然语言应对(NLP)在各个领域的应用日益广泛。尤其是写作模型的出现不仅改变了传统文本生成的途径,还为内容创作者提供了强大的工具。从新闻报道到小说创作,从学术论文到日常邮件,写作模型正逐步渗透到咱们生活的方方面面。面对众多开源的写作模型,怎样去选择和训练一个适合特定需求的模型成为了一个亟待应对的难题。本文旨在探讨当前流行的几种写作模型,并提供详细的训练指南。通过对比分析,帮助读者熟悉各模型的特点与优势,从而选择最适合本身的模型。本文还将介绍部分优秀的开源写作模型资源为读者提供参考。无论是初学者还是有经验的开发者,都能从中获得宝贵的知识和技巧。

写作模型训练

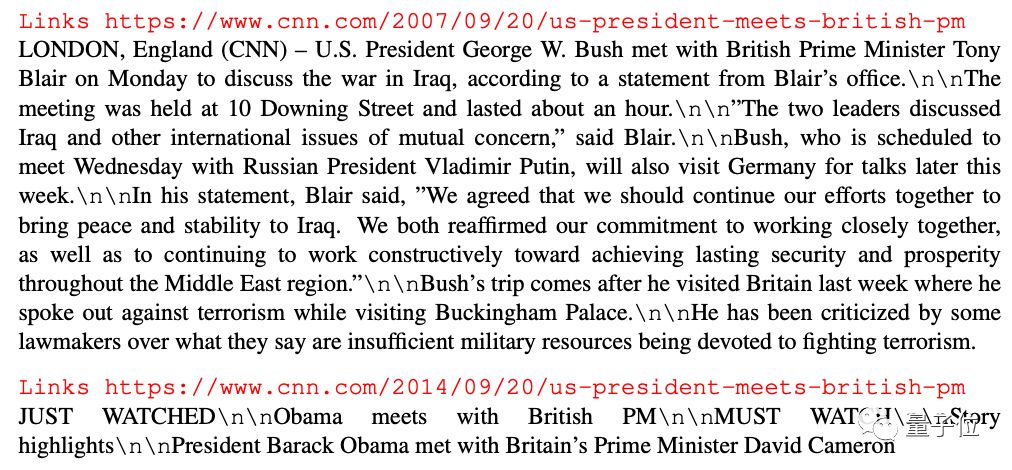

写作模型的训练是一个复杂且耗时的过程,涉及到大量的数据准备、算法选择、超参数调整等步骤。选择一个合适的预训练模型是关键。例如,BERT、GPT-2 和 T5 是目前较为流行的模型,它们在不同的任务上表现出了优异的效果。接着需要准备大量的高优劣训练数据。这包含但不限于文本数据集、语料库以及特定领域的数据。数据优劣直接作用到模型的最终性能。还需要对模型实施微调。通过在特定任务上实施微调,可以显著增强模型在特定任务上的表现。 超参数调整也是不可忽视的一环。学习率、批量大小、迭代次数等超参数的选择都会影响模型的收敛速度和最终效果。

写作模型对比

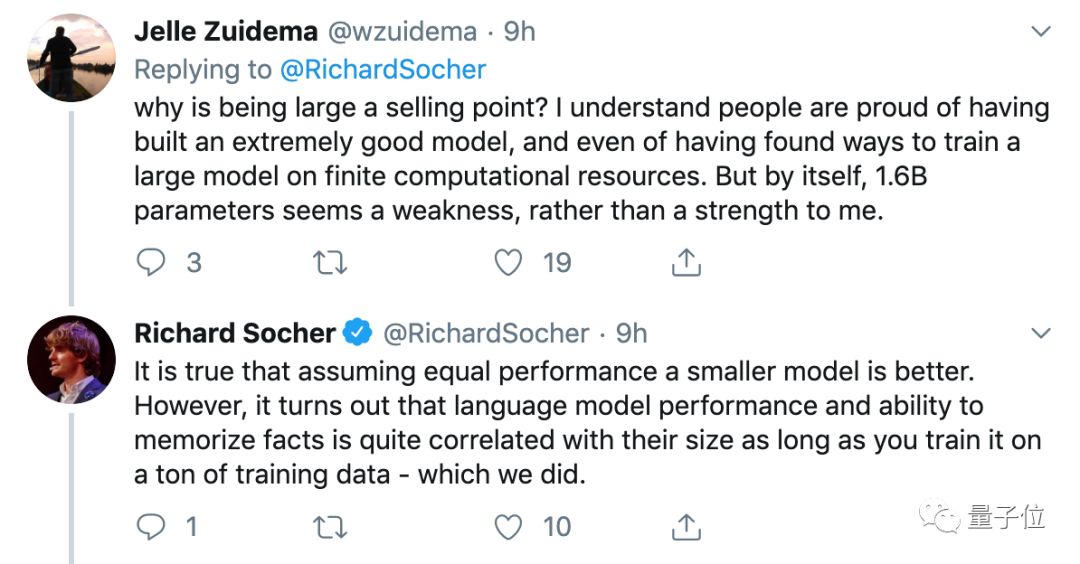

在选择写作模型时,咱们需要从多个角度实行综合考量。首先是模型的架构。BERT 以其双向Transformer结构而闻名,擅长理解上下文;GPT-2 则采用单向Transformer结构,更擅长生成连续文本;T5 模型则将任务转换为文本到文本的形式,具有更高的灵活性。其次是模型的性能。不同模型在不同任务上的表现有所差异。例如,在情感分析任务中,BERT 表现较好;而在文本生成任务中,GPT-2 的效果更为出色。模型的训练成本也是一个必不可少考虑因素。训练一个高性能的模型需要大量的计算资源和时间,于是选择一个性价比高的模型尤为关键。 模型的易用性和社区支持也值得考虑。部分模型如Hugging Face Transformers 提供了丰富的文档和教程使得模型的采用更加便捷。

写作模型开源

开源写作模型的出现极大地推动了自然语言应对领域的发展。其中,Hugging Face 是一个非常受欢迎的平台,它提供了大量高优劣的预训练模型和丰富的工具包。例如,Transformers 库包含了各种预训练模型,如BERT、GPT-2、RoBERTa 等,客户能够直接并利用。除了Hugging Face,Google 的TensorFlow Hub 也提供了多种预训练模型。这些模型不仅能够用于文本分类、情感分析等常见任务还能够用于更复杂的任务,如机器翻译和对话系统。开源模型的另一个优点在于其强大的社区支持。活跃的开发者社区不仅提供了丰富的文档和教程,还不断贡献新的模型和改进现有的模型。这使得客户可轻松地获取最新的研究成果和技术进展。

写作模型推荐

在众多开源写作模型中有几个模型因其卓越的性能和广泛的适用性而受到推荐。首先是BERT它在多项自然语言理解任务上表现出色,尤其是在情感分析、命名实体识别等领域。GPT-2 是一个强大的文本生成模型,能够生成连贯且富有创意的文本,适用于新闻撰写、故事创作等场景。T5 模型以其灵活的任务适应性而备受关注它能够应对各种文本到文本的任务,如摘要生成、问答系统等。对需要高精度和实时性的应用场景,能够考虑采用DistilBERT,这是一个轻量级版本的BERT保留了主要功能的同时大幅减少了计算成本。对期待快速入门的客户,可尝试利用RoBERTa该模型基于BERT实施了改进性能更好且易于上手。

写作模型怎么训练

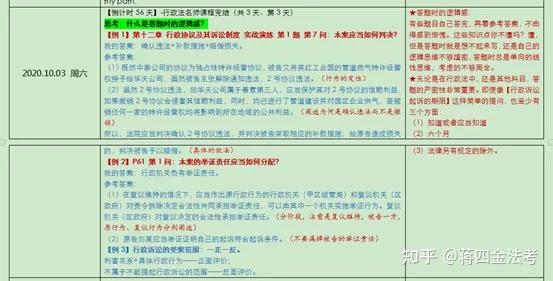

训练一个写作模型涉及多个关键步骤。需要选择一个合适的预训练模型作为基础。例如,可选择BERT、GPT-2 或是说T5 等模型。准备训练数据集。数据集的品质直接影响到模型的最终效果。高品质的数据集应包含多样化的文本样本,覆盖不同风格和主题。数据预解决是必不可少的一步,涵盖分词、去除停用词、标记化等操作。 开始模型训练。在训练进展中需要设置合适的超参数,如学习率、批量大小、迭代次数等。为了升级模型的泛化能力,可采用交叉验证的方法。 评估模型性能。常见的评估指标包含准确率、召回率、F1 分数等。依照评估结果能够进一步调整模型参数,以优化模型的表现。

通过上述步骤,我们可训练出一个高优劣的写作模型。无论是实施文本生成、文本分类还是其他自然语言应对任务,一个经过精心训练的模型都能提供出色的性能和使用者体验。

- 2024ai学习丨AI写作助手:提升创作效率与质量的关键工具

- 2024ai学习丨ai写作助手的意义在哪:探索其在科研SCI论文中的应用与实用性

- 2024ai知识丨探索AI写作助手的价值:如何优化创作流程与提升写作效率

- 2024ai知识丨探讨学术写作在通用学术英语领域的重要性

- 2024ai通丨学术写作的定义及其特点与参考文献

- 2024ai知识丨全面解析学术写作技巧:《学术写作原来是这样》PDF指南

- 2024ai通丨智能写作助手在学术领域的利与弊:AI双刃剑效应解析

- 2024ai学习丨学术写作AI:双刃剑与定义解析PDF

- 2024ai通丨掌握AI脚本编写技巧:从入门到精通全解析

- 2024ai通丨探索抖音AI创作新趋势:功能、玩法及未来展望