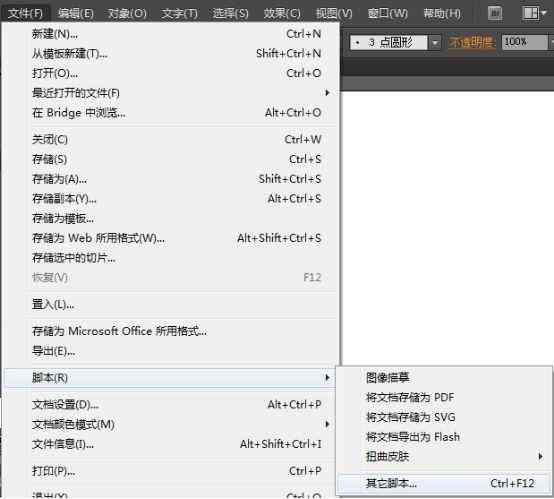

# 脚本编写与安装方法:深入解析

随着人工智能技术的发展越来越多的应用场景需要通过编写脚本来实现特定的功能。无论是机器学习模型的训练、自然语言解决的应用还是图像识别系统的构建脚本都扮演着至关必不可少的角色。本文将详细探讨怎么样编写脚本并介绍相关的安装方法。

## 一、明确需求:脚本开发的起点

在开始编写任何脚本之前首先要明确你期望实现什么样的功能。例如倘使你正在构建一个用于自动回答客户疑惑的聊天机器人你需要考虑以下几个关键点:

- 数据源:你需要从哪里获取客户的难题数据?

- 算法选择:你打算利用哪种算法来应对这些数据?

- 输出形式:最终生成的回答将以何种形式呈现?

在明确了这些基本需求之后接下来的步骤就是确定所需的模块和算法。对聊天机器人的例子而言可能需要文本预应对模块、自然语言理解(NLU)模块以及自然语言生成(NLG)模块。同时为了提升聊天机器人的性能可能还需要集成部分先进的机器学习算法,如循环神经网络(RNN)或长短时记忆网络(LSTM)。

## 二、编写脚本框架:搭建应用的基础

在明确了需求之后,下一步是编写脚本框架。这一步骤常常涵盖以下几部分:

2.1 环境准备

确信你的开发环境已经配置好。这一般涉及到安装必要的软件包和库,例如Python、TensorFlow、PyTorch等。这些库提供了强大的工具和函数,可帮助咱们更高效地实施开发。以Python为例,你可以通过运行以下命令来安装所需的库:

```bash

pip install tensorflow

pip install torch

```

2.2 数据预应对

数据预解决是项目中非常必不可少的一步。它涉及将原始数据转换为适合模型输入的格式。对于聊天机器人对于,这可能涵盖文本清洗、分词、去除停用词等操作。你可利用Python中的nltk库来实施这些预解决工作。

```python

import nltk

from nltk.corpus import stopwords

from nltk.tokenize import word_tokenize

# 停用词列表

nltk.download('stopwords')

nltk.download('punkt')

def preprocess_text(text):

# 分词

words = word_tokenize(text)

# 去除停用词

filtered_words = [word for word in words if word.lower() not in stopwords.words('english')]

return ' '.join(filtered_words)

# 示例

text = This is an example sentence.

processed_text = preprocess_text(text)

print(processed_text)

```

2.3 模型构建

模型构建是整个脚本的核心部分。按照需求的不同,可选择不同的模型结构。例如,对于聊天机器人对于,可以采用序列到序列(Seq2Seq)模型,该模型由编码器和解码器组成。编码器负责将输入序列转换为固定长度的向量,而解码器则负责依照这个向量生成相应的输出序列。

```python

import tensorflow as tf

from tensorflow.keras.models import Model

from tensorflow.keras.layers import Input, LSTM, Embedding, Dense

# 定义模型参数

embedding_dim = 256

units = 512

# 编码器

encoder_inputs = Input(shape=(None,))

enc_emb = Embedding(vocab_size, embedding_dim)(encoder_inputs)

encoder_lstm = LSTM(units, return_state=True)

encoder_outputs, state_h, state_c = encoder_lstm(enc_emb)

encoder_states = [state_h, state_c]

# 解码器

decoder_inputs = Input(shape=(None,))

dec_emb_layer = Embedding(vocab_size, embedding_dim)

dec_emb = dec_emb_layer(decoder_inputs)

decoder_lstm = LSTM(units, return_sequences=True, return_state=True)

decoder_outputs, _, _ = decoder_lstm(dec_emb, initial_state=encoder_states)

decoder_dense = Dense(vocab_size, activation='softmax')

decoder_outputs = decoder_dense(decoder_outputs)

# 构建模型

model = Model([encoder_inputs, decoder_inputs], decoder_outputs)

```

## 三、调试与优化:提升脚本性能的关键

在编写完脚本并构建好模型之后,下一步是实行调试和优化。这一步骤的目的是保证模型可以正确地解决数据,并达到预期的效果。具体对于,可通过以下几种形式来实施调试和优化:

3.1 调试代码

在编写脚本的期间,可能存在遇到各种各样的难题。 学会利用调试工具是非常关键的。例如,在Python中,能够利用pdb库来实施代码调试。通过设置断点和单步实施,能够逐步检查程序的实施流程,从而发现并解决疑惑。

```python

import pdb

def some_function(data):

# 设置断点

pdb.set_trace()

result = data 1

return result

some_function(10)

```

3.2 优化模型

除了调试代码之外,还需要对模型本身实行优化。这可能涉及到调整模型的超参数、增加更多的训练数据或改进模型的架构。例如,能够通过网格搜索(Grid Search)来寻找更优的超参数组合,从而升级模型的性能。

```python

from sklearn.model_selection import GridSearchCV

from sklearn.svm import SVC

# 定义超参数网格

param_grid = {'C': [0.1, 1, 10], 'gamma': [0.001, 0.01, 0.1]}

# 创建SVM模型

svm = SVC()

# 采用GridSearchCV实施网格搜索

grid_search = GridSearchCV(svm, param_grid, cv=5)

grid_search.fit(X_trn, y_trn)

# 输出更优的超参数组合

print(grid_search.best_params_)

```

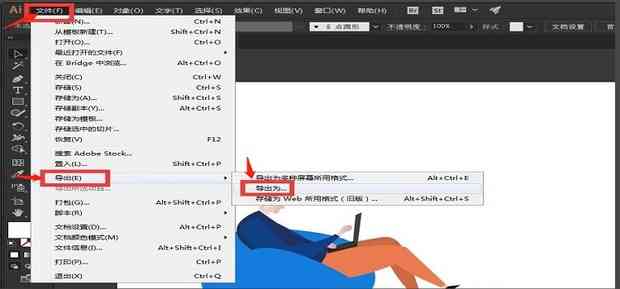

## 四、安装与部署:将脚本投入实际应用

最后一步是将编写好的脚本安装到目标环境中并实行部署。这一步骤的目的是保证脚本能够在生产环境中正常运行,从而为客户提供所需的服务。具体而言,能够通过以下几种办法实施安装与部署:

4.1 配置服务器环境

在部署脚本之前,首先需要保障目标服务器的环境已经配置好。这可能包含安装操作系统、数据库、Web服务器等。例如,要是你打算将脚本部署到Linux服务器上,那么需要先安装Ubuntu操作系统,并配置好Apache Web服务器。

```bash

# 更新软件包列表

sudo apt-get update

# 安装Apache Web服务器

sudo apt-get install apache2

```

4.2 部署脚本

在配置好服务器环境之后,就可将编写好的脚本部署到服务器上了。这一步骤往往包含上传脚本文件、创建虚拟环境、安装依赖库等。例如,可利用Git工具将脚本文件上传到服务器上的指定目录,并通过Docker容器来运行脚本。

```bash

# 克隆脚本仓库

git clone https://github.com/yourusername/yourscript.git

# 创建虚拟环境

virtualenv venv

# 激活虚拟环境

source venv/bin/activate

# 安装依赖库

pip install -r requirements.txt

# 运行脚本

python mn.py

```

4.3 监控与维护

一旦脚本成功部署到生产环境中,就需要对其实施监控和维护。这一步骤的目的是确信脚本能够持续稳定地运行,并及时发现和解决可能出现的疑问。具体对于,能够通过日志分析、性能监控等办法来实施监控和维护。

```python

import logging

# 配置日志记录

logging.basicConfig(filename='.log', level=logging.INFO)

# 记录日志信息

logging.info(' script started.')

```

## 总结

通过以上几个步骤,我们能够编写出高品质的脚本,并将其部署到实际应用中。在这个期间,需要充分考虑需求分析、脚本框架设计、调试与优化以及安装与部署等方面。只有这样,才能确信脚本能够满足客户的需求,并发挥其应有的作用。

- 2024ai学习丨AI创作中心源码解析:AI创作著作权归属探讨

- 2024ai学习丨全面解析:学生AI创作比赛策划全攻略与实施方案

- 2024ai知识丨青少年AI创意编程挑战:学生AI创作竞赛方案撰写攻略

- 2024ai知识丨学生AI创作比赛方案设计:撰写指南与模板大全

- 2024ai知识丨提升AI文案原创性:全面攻略与高级技巧

- 2024ai学习丨精选AI壁纸文案素材,高清无水印一键体验

- 2024ai通丨全面指南:如何为幼儿园撰写结合AI体育游戏的教育文案

- 2024ai知识丨掌握AI小红书攻略:撰写高效教程文案全解析

- 2024ai通丨ai脚本合集69:从入门到精通及插件使用指南

- 2024ai知识丨全面盘点:主流AI写作工具及其应用范围与功能比较