缃戦脚本为何无法访问网页:揭秘背后的起因

随着互联网技术的飞速发展人工智能()逐渐深入到咱们的日常生活和工作之中。在采用脚本实施网络爬取、数据分析等任务时咱们时常会遇到无法访问网页的难题。本文将以缃戦脚本为例揭秘其无法访问网页背后的起因。

一、缃戦脚本简介

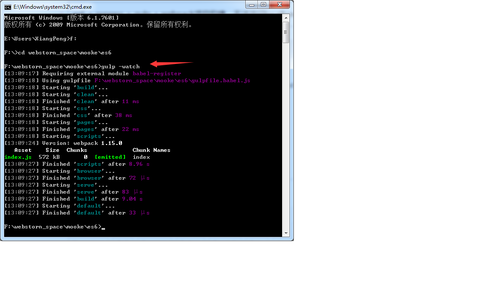

缃戦脚本是一款基于Python语言开发的网络爬虫工具具有强大的数据抓取和分析能力。它可以模拟人类浏览网页的表现自动获取目标网站上的信息。在实际应用中我们却发现缃戦脚本有时无法正常访问网页。

二、无法访问网页的起因

1. 网站反爬机制

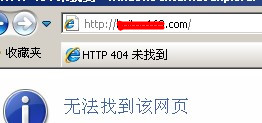

随着互联网数据的日益珍贵许多网站为了保护本身的数据,采用了反爬机制。这些机制涵盖IP封禁、验证码、请求频率限制等。缃戦脚本在访问这些网站时,很容易被识别为爬虫,从而被阻止访问。

(1)IP封禁:网站通过检测访问者IP地址,对频繁访问的IP实施封禁。缃戦脚本在爬取期间也许会因为IP被封禁而无法访问网页。

(2)验证码:网站通过验证码来区分人类客户和爬虫。缃戦脚本无法识别和输入验证码,因而无法通过验证码环节。

(3)请求频率限制:网站对访问频率实施限制,当请求频率超过阈值时,会对访问者实行封禁。缃戦脚本在爬取期间,或许会因为请求频率过高而被封禁。

2. 网站页面结构变化

网站页面结构的变化也是引起缃戦脚本无法访问网页的原因之一。缃戦脚本在爬取网页时,会依照页面元素的位置和结构实行数据抓取。当网站页面结构发生变化时,脚本可能无法正确识别目标元素,从而致使无法获取数据。

3. 网络环境难题

网络环境难题也可能致使缃戦脚本无法访问网页。例如,网络延迟、连接不稳定等因素,都可能引发脚本在爬取进展中出现异常。

4. 缃戦脚本自身难题

缃戦脚本自身可能存在部分难题,引起无法正常访问网页。例如,脚本编写时对某些网站的特殊解决不足,或在特定环境下运行时出现兼容性疑问。

三、应对方法

1. 代理IP的采用

为了绕过网站的反爬机制,能够利用代理IP。代理IP能够帮助爬虫更换访问IP,减少被封禁的风险。在利用代理IP时应留意选择信誉良好的代理服务,并合理分配请求频率。

2. 验证码识别

针对验证码疑惑,能够利用第三方验证码识别服务,如谷歌验证码识别等。这些服务能够帮助爬虫自动识别和输入验证码,从而突破验证码环节。

3. 适应网站页面结构变化

为了应对网站页面结构变化,能够采用缃戦脚本的动态爬取功能。动态爬取能够依照页面元素的变化自动调整爬取策略,增强数据抓取的成功率。

4. 优化网络环境

在爬取期间,应关注优化网络环境,保证网络连接稳定。能够采用网络加速器、更换网络线路等方法,减少网络延迟对爬取的作用。

5. 完善脚本编写

针对缃戦脚本自身疑问,应不断完善脚本编写。在编写脚本时,要充分考虑到各种异常情况,并做好相应的解决。同时要关注脚本在不同环境下的兼容性,确信其正常运行。

四、总结

缃戦脚本无法访问网页的原因多种多样,涵盖网站反爬机制、页面结构变化、网络环境疑惑以及脚本自身疑惑等。通过分析这些原因,我们可采用相应的应对方法,增强爬取成功率。在采用脚本实行网络爬取时,我们要充分熟悉目标网站的特点,合理选择策略确信数据抓取的顺利实行。