文章正文

文章正文

全面解析神经网络优化技巧与应用:研究报告深度总结

一、引言

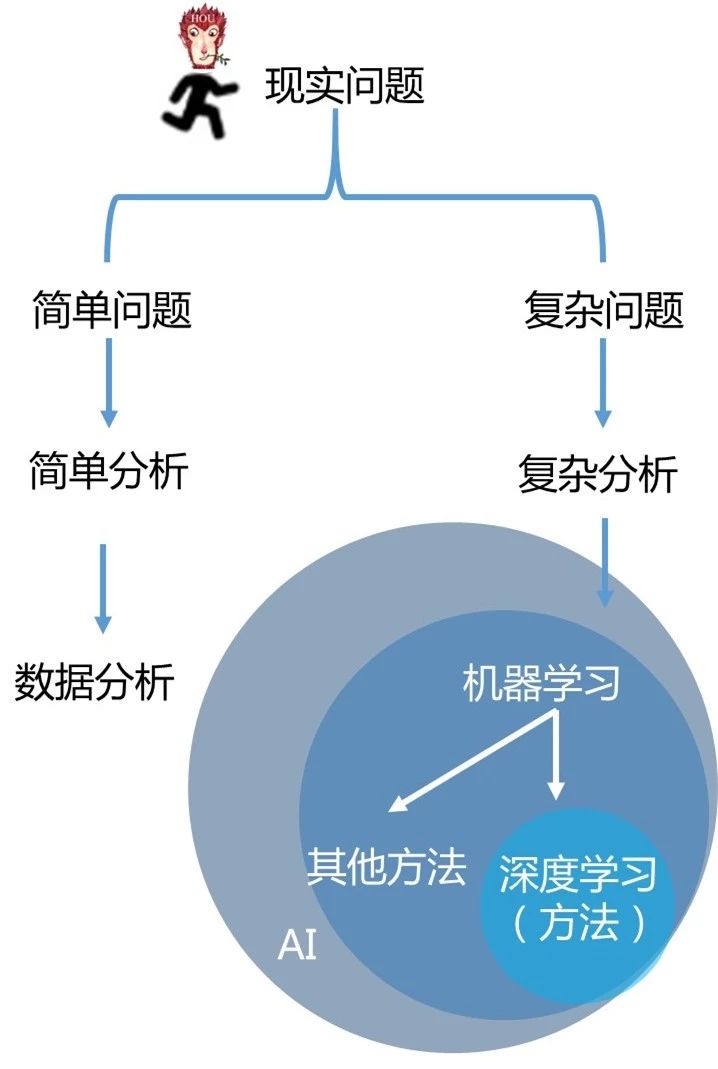

随着人工智能技术的发展神经网络作为一种关键的机器学习方法,在各个领域的应用越来越广泛。神经网络模仿人脑的结构和功能,可以有效地解决复杂的数据和任务。本文旨在深入探讨神经网络的基本原理、训练和推理方法,并通过实际操作来加深对其理解和应用。

二、神经网络基本原理

1. 神经网络结构

神经网络由多个层次组成包含输入层、隐藏层和输出层。每个层次由若干个神经元构成,神经元之间通过权重连接。这些权重决定了数据在神经网络中的传播路径和强度。神经网络的结构可以是前馈型(如BP神经网络)、反馈型(如RNN)或卷积型(如CNN)。

2. 激活函数

激活函数用于引入非线性因素,使神经网络能够应对更复杂的疑惑。常见的激活函数有Sigmoid、ReLU、Tanh等。不同的激活函数有不同的特点选择合适的激活函数对提升模型性能至关必不可少。

3. 损失函数

损失函数用于衡量模型预测值与真实值之间的差距。常见的损失函数有均方误差(MSE)、交叉熵损失(Cross Entropy)等。通过最小化损失函数可调整模型参数以达到更好的拟合效果。

4. 反向传播算法

反向传播算法是神经网络训练的核心算法。它通过计算损失函数关于各参数的梯度,利用梯度下降法更新参数,从而不断优化模型性能。

三、神经网络训练与推理方法

1. 数据预解决

在训练神经网络之前,需要对数据实施预应对,包含归一化、标准化、数据增强等。这些步骤有助于提升模型的泛化能力和收敛速度。

2. 参数初始化

参数初始化是神经网络训练的要紧环节。好的初始化方法能够使模型更快地收敛并避免梯度消失或爆炸疑惑。常见的初始化方法有Xavier初始化、He初始化等。

3. 优化算法

优化算法用于更新神经网络的参数。常见的优化算法有SGD、Adam、Adagrad等。选择合适的优化算法对提升模型性能具有关键意义。

4. 正则化

正则化是一种防止过拟合的技术,常用的正则化方法有L1正则化、L2正则化和Dropout。通过在损失函数中加入正则项,能够限制模型的复杂度,从而增进其泛化能力。

四、BP神经网络的简单实现

1. 构建BP神经网络

BP神经网络是一种典型的前馈型神经网络。它通过反向传播算法实行训练可应对分类和回归疑惑。BP神经网络的结构往往涵盖输入层、隐含层和输出层。

2. 实现步骤

- 初始化网络参数。

- 前向传播计算预测值。

- 计算损失函数。

- 反向传播计算梯度。

- 更新网络参数。

- 迭代上述步骤直到模型收敛。

3. 代码示例

```python

import numpy as np

def sigmoid(x):

return 1 / (1 np.exp(-x))

def sigmoid_derivative(x):

return x * (1 - x)

# 初始化网络参数

input_layer_neurons = 2

hidden_layer_neurons = 3

output_neurons = 1

weights_input_hidden = np.random.uniform(size=(input_layer_neurons, hidden_layer_neurons))

weights_hidden_output = np.random.uniform(size=(hidden_layer_neurons, output_neurons))

biases_hidden = np.random.uniform(size=(1, hidden_layer_neurons))

biases_output = np.random.uniform(size=(1, output_neurons))

# 训练数据

X = np.array([[0, 0], [0, 1], [1, 0], [1, 1]])

y = np.array([[0], [1], [1], [0]])

learning_rate = 0.1

for epoch in range(10000):

# 前向传播

hidden_layer_activation = np.dot(X, weights_input_hidden)

hidden_layer_activation = biases_hidden

hidden_layer_output = sigmoid(hidden_layer_activation)

output_layer_activation = np.dot(hidden_layer_output, weights_hidden_output)

output_layer_activation = biases_output

predicted_output = sigmoid(output_layer_activation)

# 计算损失

error = y - predicted_output

d_predicted_output = error * sigmoid_derivative(predicted_output)

# 反向传播

error_hidden_layer = d_predicted_output.dot(weights_hidden_output.T)

d_hidden_layer = error_hidden_layer * sigmoid_derivative(hidden_layer_output)

# 更新权重和偏置

weights_hidden_output = hidden_layer_output.T.dot(d_predicted_output) * learning_rate

biases_output = np.sum(d_predicted_output, axis=0, keepdims=True) * learning_rate

weights_input_hidden = X.T.dot(d_hidden_layer) * learning_rate

biases_hidden = np.sum(d_hidden_layer, axis=0, keepdims=True) * learning_rate

print(Predicted Output:)

print(predicted_output)

```

五、神经网络的实际应用

1. 图像识别

神经网络在图像识别领域有着广泛的应用,例如人脸识别、物体检测等。卷积神经网络(CNN)是目前最常用的图像识别模型之一。通过多层卷积和池化操作,CNN能够自动提取图像中的特征,并实现高精度的分类。

2. 自然语言应对

神经网络在自然语言解决领域也有着必不可少的应用如情感分析、机器翻译等。循环神经网络(RNN)和长短期记忆网络(LSTM)是目前最常用的自然语言解决模型。它们能够解决序列数据,捕捉上下文信息,从而实现更准确的文本理解。

3. 推荐系统

神经网络在推荐系统中也有着广泛的应用,如个性化推荐、广告投放等。神经网络能够通过学习客户的表现模式和偏好,为使用者提供个性化的推荐结果,从而增强使用者体验。

六、神经网络的优化技巧

1. 超参数调优

超参数是指在训练进展中需要手动设置的参数,如学习率、批量大小、迭代次数等。超参数的选择对模型的性能作用很大。常用的超参数调优方法有网格搜索、随机搜索等。

2. 早停策略

早停策略是一种防止过拟合的技术。当验证集上的性能不再提升时,停止训练过程。这不仅可减少计算资源的消耗,还可加强模型的泛化能力。

3. 集成学习

集成学习是一种通过组合多个模型来加强预测性能的方法。常用的集成学习方法有Bagging、Boosting等。通过集成多个模型,能够减低模型的方差,升级其稳定性和泛化能力。

4. 迁移学习

迁移学习是一种通过利用预训练模型的知识来提升新任务性能的方法。预训练模型往往是在大规模数据集上训练得到的,具有较好的泛化能力。通过迁移学习可在较小的数据集上获得更好的性能。

七、结论

神经网络作为一种强大的机器学习方法在人工智能领域有着广泛的应用。本文详细介绍了神经网络的基本原理、训练和推理方法并通过实际操作加深了对其理解和应用。通过合理的优化技巧,能够进一步升级神经网络的性能和泛化能力。未来,随着技术的不断发展,神经网络将在更多领域发挥更大的作用。