文章正文

文章正文

引言

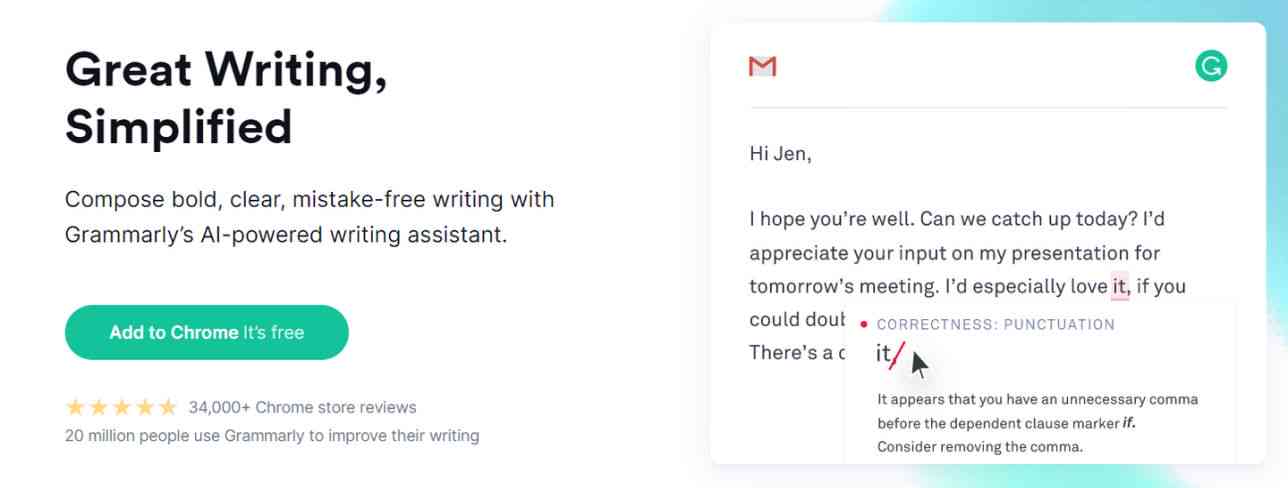

在这个数字化和智能化的时代人工智能()已经渗透到咱们生活的方方面面其中写作软件更是以其高效、精准的特点受到了广泛的关注。无论是撰写文章、创作诗歌还是生成报告写作软件都能极大地增进工作效率。市面上的写作软件往往价格不菲且功能未必完全符合个人需求。 学会自身动手打造一款属于自身的写作软件就显得尤为要紧。本指南将为你提供一个从零开始构建写作软件的全过程包含必要的理论知识、编程技巧以及实际操作步骤。无论你是编程新手还是有一定基础的开发者都可通过本指南快速入门掌握写作软件开发的核心技能。同时本文还会提供丰富的资源和工具,帮助你轻松完成项目。期待通过本指南,你可以实现自身的写作梦想,创造出独一无二的作品。

怎么样本人创建写作软件教程安装

并安装Python

在开始编写代码之前你需要保障计算机上已经安装了Python环境。Python是一种高级编程语言,广泛用于数据应对、机器学习和自然语言解决等领域。访问Python官方网站(https://www.python.org/downloads/),依据你的操作系统(Windows、MacOS或Linux)对应的最新版本Python安装包。对Windows使用者,建议选择包含pip的安装包,这样可方便地管理后续所需的库。安装进展中,请勾选“Add Python to PATH”选项,以便于之后的采用。安装完成后打开命令提示符(Windows)或终端(MacOS/Linux),输入`python --version`命令,假如出现Python版本号,则说明安装成功。

安装必要的库

需要安装若干必要的Python库,以支持写作软件的功能。常用的库涵盖NumPy、Pandas、NLTK、TensorFlow和Transformers等。打开命令提示符或终端,依次运行以下命令:

```

pip install numpy pandas nltk tensorflow transformers

```

安装完成后,可以通过简单的测试代码验证安装是不是成功。例如,在Python环境中输入以下代码:

```python

import numpy as np

print(np.__version__)

```

要是输出了NumPy的版本号,则表示安装成功。

配置开发环境

为了更高效地实施开发,建议配置一个集成开发环境(IDE)。目前主流的IDE有Visual Studio Code、PyCharm和Jupyter Notebook等。这里推荐采用Visual Studio Code,因为它不仅支持多种编程语言还提供了强大的插件系统,可帮助你更方便地编写和调试代码。访问Visual Studio Code官网(https://code.visualstudio.com/)安装包。安装完成后,启动Visual Studio Code,点击左侧的扩展图标,搜索并安装Python插件这将为你的Python开发提供语法高亮、代码补全等功能。还能够安装其他插件,如GitLens、Code Spell Checker等,以增强开发体验。

理解基本概念

在正式开始编程之前,需要先对写作软件的基本概念有一个初步的理解。写作软件的核心在于自然语言解决(NLP),它是一门利用计算机解决和理解人类语言的技术。常见的NLP任务涵盖文本分类、情感分析、机器翻译和文本生成等。在本指南中,咱们将重点放在文本生成上。文本生成多数情况下采用深度学习模型,如循环神经网络(RNN)、长短时记忆网络(LSTM)和Transformer等。这些模型能够按照给定的上下文自动生成连贯的文本。为了更好地理解这些模型的工作原理,你可阅读相关的学术论文和教程。例如,可参考Google的《Attention is All You Need》论文,该论文介绍了Transformer模型,并对其在自然语言应对中的应用实行了详细的阐述。

创建项目结构

为了使项目更加清晰和易于维护,建议先创建一个合理的项目结构。打开Visual Studio Code,新建一个文件夹作为项目的根目录,然后在该文件夹内创建以下子文件夹和文件:

- `data/`:存放训练数据和预解决后的数据。

- `models/`:存放训练好的模型。

- `utils/`:存放辅助函数和工具类。

- `config.py`:存放项目配置信息。

- `mn.py`:主程序入口。

- `trn.py`:训练脚本。

- `predict.py`:预测脚本。

编写训练脚本

咱们将编写训练脚本。打开`trn.py`文件,首先导入所需的库和模块:

```python

import os

import torch

from torch.utils.data import DataLoader

from transformers import BertTokenizer, BertForMaskedLM

from utils.dataset import TextDataset

from config import MAX_LEN, BATCH_SIZE, NUM_EPOCHS, LEARNING_RATE

```

接着定义训练函数:

```python

def trn(model, tokenizer, trn_loader, optimizer, num_epochs):

model.trn()

for epoch in range(num_epochs):

total_loss = 0

for batch in trn_loader:

input_ids = batch['input_ids'].to(device)

attention_mask = batch['attention_mask'].to(device)

labels = batch['labels'].to(device)

optimizer.zero_grad()

outputs = model(input_ids, attention_mask=attention_mask, labels=labels)

loss = outputs.loss

loss.backward()

optimizer.step()

total_loss = loss.item()

print(fEpoch {epoch 1}/{num_epochs}, Loss: {total_loss / len(trn_loader)})

```

运行训练脚本

我们需要准备训练数据并运行训练脚本。假设你已经有了一个包含大量文本的数据集,将其保存为CSV文件格式。利用Pandas库读取数据,并调用`trn`函数实施训练:

```python

if __name__ == __mn__:

device = torch.device(cuda if torch.cuda.is_avlable() else cpu)

tokenizer = BertTokenizer.from_pretrned('bert-base-uncased')

model = BertForMaskedLM.from_pretrned('bert-base-uncased').to(device)

dataset = TextDataset(tokenizer, data_file='path/to/data.csv', max_len=MAX_LEN)

trn_loader = DataLoader(dataset, batch_size=BATCH_SIZE, shuffle=True)

optimizer = torch.optim.Adam(model.parameters(), lr=LEARNING_RATE)

trn(model, tokenizer, trn_loader, optimizer, NUM_EPOCHS)

```

训练完成后,模型将会保存在`models/`目录下,以便后续采用。