文章正文

文章正文

在科技飞速发展的今天人工智能()已经渗透到了咱们生活的方方面面。其中写作模型作为一种新兴的技术正逐步改变着内容创作的格局。它不仅可以高效地生成文章、报告还能在创意写作、新闻撰写等领域大放异彩。本文将带领读者探索写作模型的无限可能从对比、开源、训练、推荐到模型库逐一解析这一技术的魅力所在。

一、写作模型的无限可能

写作模型的诞生为人类带来了前所未有的便利。它不仅能够节省大量的时间和精力还能在保持内容品质的前提下实现高效率的创作。随着技术的不断进步写作模型的潜力正在被不断挖掘,它的无限可能正逐渐呈现在咱们眼前。

二、写作模型对比

1. GPT-3与GPT-2

GPT-3是Open推出的第三代自然语言解决模型,相较于GPT-2,它在参数规模、语言理解和生成能力等方面都有显著提升。GPT-3能够生成更加流畅、自然的文章,而且能够更好地理解人类的意图和语境。GPT-3的训练成本和运行成本较高,不适合所有场景。

2. GLM-4与BERT

GLM-4是和智谱共同推出的自然语言解决模型,BERT则是Google推出的预训练模型。两者在生成能力和语言理解方面都有不错的表现。BERT在预训练阶段引入了大量的语料库,使得它在理解人类语言方面具有更强的能力。而GLM-4则在生成能力上更具优势,能够生成更加多样化的文本。

三、写作模型开源

1. TensorFlow

TensorFlow是Google开源的机器学习框架,它提供了丰富的工具和库,使得开发者能够轻松构建和训练实习小编。TensorFlow支持多种编程语言,如Python、C 和Java等,使得写作模型的开发更加便捷。

2. PyTorch

PyTorch是Facebook开源的机器学习库,它以其简洁的代码和动态计算图受到了广大开发者的喜爱。PyTorch支持动态图计算,使得模型的调试和优化更加容易。PyTorch还提供了丰富的预训练模型,如GPT-2、BERT等,方便开发者快速搭建写作模型。

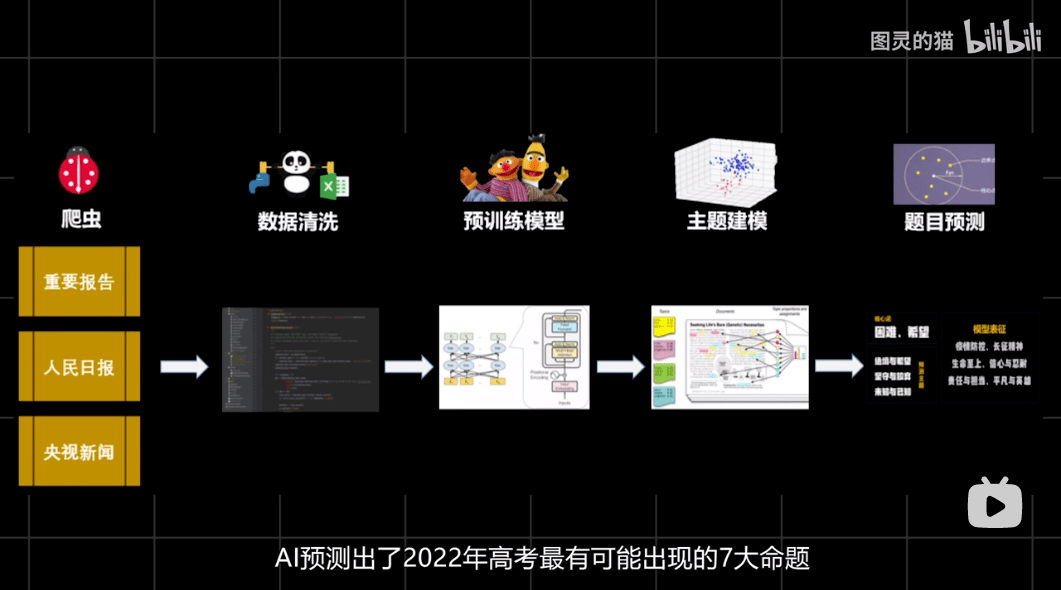

四、写作模型怎么训练

1. 数据收集

训练写作模型需要大量的文本数据。这些数据可从网络上的文章、书籍、论坛等地方获取。为了保证模型的品质,需要对数据实行清洗和预解决去除噪声和重复内容。

2. 预训练

预训练是写作模型训练的要紧环节。通过预训练,模型能够学习到大量的语言知识和模式。预训练常常采用无监督学习的形式,利用大规模的文本数据对模型实行训练。

3. 微调

微调是针对特定任务对预训练模型实施优化的过程。通过微调,模型能够更好地适应具体的写作任务。微调期间,需要对模型实行有监督的学习,利用标注的数据对模型实行训练。

五、写作模型推荐

1. GPT-3

GPT-3是当前的自然语言解决模型之一,它的生成能力和语言理解能力都非常强大。若是你需要生成高品质的文章、报告或实行创意写作,GPT-3是一个不错的选择。

2. BERT

BERT在语言理解方面具有显著的优势,适合实行文本分类、情感分析等任务。假如你需要对大量文本实行快速应对和分析,BERT将是一个很好的选择。

3. GLM-4

GLM-4在生成能力上具有优势,能够生成多样化、自然的文本。假如你需要生成具有创意性的文本,如诗歌、小说等,GLM-4将是一个不错的选择。

六、写作模型库

1. Hugging Face

Hugging Face是一个开源的自然语言解决模型库,它提供了大量的预训练模型和工具,方便开发者搭建和部署写作模型。

2. Model Zoo

Model Zoo是百度开源的机器学习模型库,它包含了多种自然语言解决模型,如BERT、GPT等。Model Zoo提供了丰富的模型和工具,助力开发者快速搭建写作模型。

写作模型作为一种新兴的技术,正逐步改变着内容创作的格局。从对比、开源、训练、推荐到模型库我们可看到写作模型的无限可能。随着技术的不断进步,我们有理由相信,写作模型将在未来发挥更大的作用,为人类带来更多的便利。