文章正文

文章正文

引言

在当今信息爆炸的时代人们越来越依赖人工智能技术实施各种内容创作从日常的新闻报道到复杂的学术论文,从广告文案到社交媒体上的短文。随着写作技术的发展怎样保证生成内容的特别性和原创性成为了一个亟待应对的疑惑。本文将深入探讨写作背后的原理,并详细分析怎样通过算法和技术手段来避免重复疑问。咱们先要熟悉什么是写作,以及其基本工作原理。我们将剖析写作中所采用的算法,包含深度学习模型和自然语言应对技术。 我们将讨论写作进展中可能遇到的重复疑问,并介绍部分有效的应对方案。

写作是什么

写作是指利用人工智能技术自动生成文本内容的过程。此类技术结合了自然语言应对(NLP)和机器学习算法,使计算机可以理解和生成人类语言。写作的核心在于让机器模拟人类的写作过程,不仅涵盖文本的生成,还包含对上下文的理解、逻辑推理以及情感表达等方面。写作可以广泛应用于多个领域,如新闻撰写、报告生成、剧本创作等。它不仅可以升级效率,还能为客户提供多样化的文本内容。通过写作,我们可获得高优劣、高效率的文本内容,而无需耗费大量人力和时间。

写作的基本原理

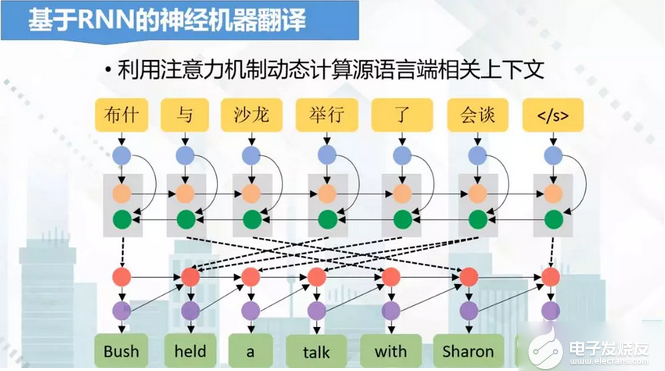

写作的基本原理主要依赖于深度学习模型和自然语言应对技术。深度学习模型是写作的核心组成部分。这些模型往往基于神经网络架构能够通过大量的训练数据学习语言模式和规律。例如,循环神经网络(RNN)、长短时记忆网络(LSTM)和Transformer模型等都是常用的深度学习模型。这些模型能够捕捉长距离依赖关系,从而更好地理解文本的结构和逻辑。自然语言解决技术则负责对输入的文本实施预应对和后解决。这包含分词、词性标注、命名实体识别等任务,以帮助模型更好地理解文本内容。自然语言解决还涉及文本生成后的校验和优化,确信生成的文本符合语法规范和语义须要。

写作算法

写作算法主要包含深度学习模型和序列生成方法。深度学习模型如Transformer和GPT-3在生成文本方面表现出色它们通过大规模的训练数据来学习语言的统计规律。这些模型采用自关注力机制,能够捕捉文本中的长距离依赖关系,使得生成的文本更具连贯性和合理性。序列生成方法则是指将文本生成视为一个逐步生成的过程。此类方法常常利用递归神经网络(RNN)或变体如LSTM和GRU来实现。这些模型在每一步生成一个单词,并按照前一个单词调整下一个单词的选择概率。为了进一步增强生成优劣,还能够引入条件生成和对抗训练等技术。条件生成允许模型在生成期间考虑特定的上下文信息,如主题或风格。对抗训练则通过生成器和判别器之间的博弈来提升生成文本的真实感和多样性。

写作会跟别人重复吗

写作是不是会与他人重复是一个关键疑问。尽管写作技术已经取得了显著进步,但重复疑问仍然存在。写作的训练数据多数情况下来自公共互联网资源,这意味着生成的内容或许会与已有的文本相似。为了避免这类疑惑,可通过增加特别的训练数据集来增进模型的多样性。即使在相同的训练数据下,不同的实习小编也会生成不同的结果。这是因为模型参数和训练策略的不同会造成不同的输出。通过引入随机性或噪声可进一步增加生成文本的多样性。例如,在生成进展中添加一定的随机性,可使生成的文本更加灵活多变。 还可采用多种不同的模型实行集成,从而增进整体的多样性。通过这些方法能够在一定程度上减少写作与他人重复的可能性。

总结

写作是一项具有广泛应用前景的技术,它能够高效地生成高优劣的文本内容。通过深度学习模型和自然语言解决技术,写作能够在保持连贯性和合理性的同时生成多样化且富有创意的文本。虽然写作存在重复疑惑但通过增加独到训练数据、引入随机性和采用模型集成等方法,能够有效缓解这一疑问。未来,随着技术的不断进步写作将会在更多领域得到应用,并为人类带来更多的便利和创新。