文章正文

文章正文

# 姿态识别模型-姿态识别模型大全

## 引言

姿态识别作为计算机视觉领域的一个必不可少分支,近年来得到了广泛关注。随着深度学习技术的快速发展,姿态识别模型层出不穷,为各类应用场景提供了强大的技术支持。本文将介绍当前主流的姿态识别模型,以HRNet为例,详细解析其原理和代码实操,并探讨姿态识别的整体过程。

## 一、姿态识别概述

姿态识别是指通过计算机技术,对图像或视频中的目标人体实行识别,提取出人体关键部位的位置信息从而实现对人体姿态的检测和分类。姿态识别技术广泛应用于虚拟现实、人机交互、运动分析等领域,具有很高的研究价值和商业潜力。

## 二、主流姿态识别模型

1. OpenPose

OpenPose是一款基于深度学习的实时多人关键点检测系统。它采用了多尺度和金字塔网络结构可以在不同分辨率下对人体关键点实行检测。OpenPose的优势在于实时性和准确性,适用于动态场景下的姿态识别。

2. HRNet

HRNet(High-Resolution Network)是一种高性能的网络结构,适用于关键点检测任务。下面咱们将详细介绍HRNet的原理和代码实操。

(1)原理

HRNet的核心思想是保持高分辨率特征,同时融合不同尺度的信息。网络结构主要由三个部分组成:基础网络、融合网络和关键点分支。

- 基础网络:采用ResNet作为基础网络提取图像特征。

- 融合网络:将不同尺度的特征实施融合加强关键点检测的准确性。

- 关键点分支:依照任务需求,设计关键点分支,对关键点实行预测。

(2)代码实操

以下是一个简化版的HRNet代码示例:

```python

import torch

import torch.nn as nn

class HRNet(nn.Module):

def __init__(self):

super(HRNet, self).__init__()

# 基础网络

self.base_network = ResNet()

# 融合网络

self.fusion_network = FusionNetwork()

# 关键点分支

self.keypoint_branch = KeypointBranch()

def forward(self, x):

base_features = self.base_network(x)

fusion_features = self.fusion_network(base_features)

keypoints = self.keypoint_branch(fusion_features)

return keypoints

# 实例化模型

model = HRNet()

# 假设输入图像为 x

x = torch.randn(1, 3, 224, 224)

# 前向传播

keypoints = model(x)

```

3. 其他姿态识别模型

除了OpenPose和HRNet还有许多其他优秀的姿态识别模型,如:

- VIBE:一种基于视频的三维人体姿态估计方法。

- Mask R-CNN:一种基于Faster R-CNN的目标检测和人体分割模型。

- PoseNet:一种基于PointNet的关键点检测和姿态估计模型。

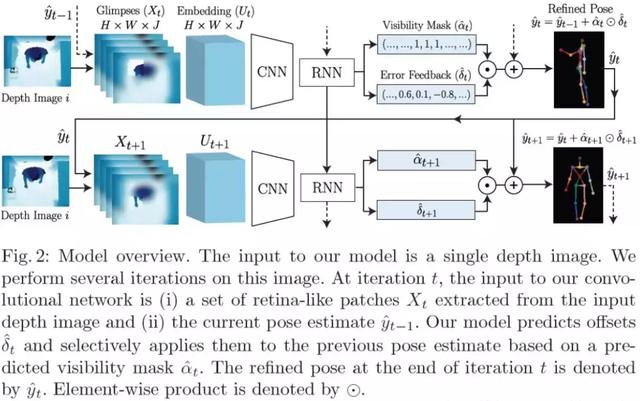

## 三、姿态识别整体过程

姿态识别的整体过程主要涵盖以下几个步骤:

1. 图像/视频输入

将输入的图像或视频送入模型实行预解决。预解决过程包含缩放、裁剪等操作,以保证输入数据符合模型的需求。

2. 人体分割

通过人体分割技术,将图像或视频中的目标人体从背景中分离出来。常用的分割方法有Mask R-CNN等。

3. 关键点检测

利用姿态识别模型对分割后的人体图像实行关键点检测。关键点检测期间,模型会输出人体关键部位的位置信息。

4. 姿态估计

依据关键点位置信息,对人体姿态实行估计。姿态估计可是二维姿态,也可是三维姿态。

5. 后解决

对检测结果实行后解决,涵盖滤波、平滑等操作,以提升关键点位置的准确性。

## 四、总结

姿态识别技术作为计算机视觉领域的一个关键研究方向具有广泛的应用前景。本文介绍了主流的姿态识别模型,如OpenPose、HRNet等,并详细解析了HRNet的原理和代码实操。同时本文还探讨了姿态识别的整体过程,为相关领域的研究提供了参考。随着技术的不断发展,姿态识别模型将越来越完善为人类生活带来更多便利。