文章正文

文章正文

探索写作背后的原理与技术

在当今信息爆炸的时代人工智能()已经渗透到咱们生活的方方面面其中写作无疑是更具吸引力的领域之一。它不仅可以帮助人们更高效地完成文字创作还能为内容生产带来前所未有的创新和多样性。从自动撰写新闻稿、博客文章到生成小说、诗歌甚至剧本写作的应用范围越来越广。对许多人而言写作背后的技术和原理仍然是一个神秘而复杂的谜团。本文将深入探讨写作的工作机制揭示其背后的科学原理和技术手段并尝试回答部分常见疑惑:写作是不是会与他人产生雷同?写作究竟是什么?写作的原理又是什么?通过这些探讨期待读者能对这一新兴领域有更全面的理解。

写作是不是会与他人产生雷同?

写作是否会与他人产生雷同这是一个复杂的疑问。写作的核心是基于大数据和机器学习算法通过对大量文本数据实施分析和学习,从而模仿人类的语言风格和表达形式。理论上,在生成文本时会参考已有的语言模式和结构,这可能造成某些情况下生成的内容与其他人的作品相似。写作系统常常会采用多种策略来避免这类情况的发生。例如,通过引入随机性和创造性算法,使得生成的文本具有一定的特别性和原创性。若干高级的写作系统还具备自我修正功能,可以检测并修改重复或过于相似的内容,确信输出结果的特别性。 在实际应用中,写作虽然可能偶尔出现雷同的情况,但总体上仍能保持较高的原创性和独到性。

写作是什么?

写作是指利用人工智能技术自动生成文本的过程。它涉及自然语言解决(NLP)、机器学习和深度学习等多个领域的技术。写作不仅仅是简单的文本生成工具,而是通过学习大量文本数据,理解语言结构和语义,从而生成高品质、连贯且富有创意的文字内容。写作的应用场景非常广泛,涵盖但不限于新闻报道、社交媒体帖子、广告文案、学术论文、小说、诗歌等。通过写作,不仅可增强内容生产的效率,还能为创作者提供灵感和辅助,使他们能够更好地专注于创意和表达。写作的核心在于其强大的语言理解和生成能力,以及对不同文体和风格的适应性。随着技术的进步,写作将不断进化,为人类创造更多可能性。

写作的原理

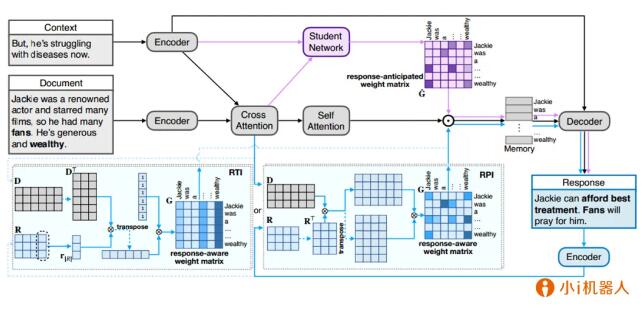

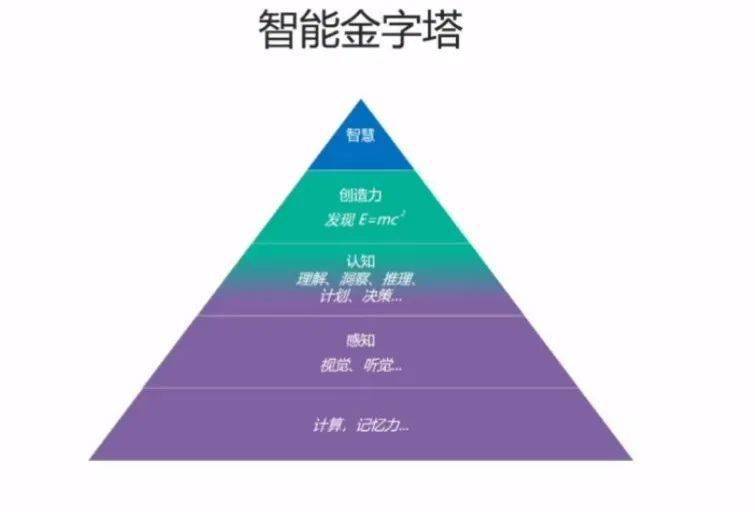

写作的原理主要基于自然语言解决(NLP)和机器学习两大核心技术。需要通过大量的文本数据实行训练,以学习语言的基本规则和结构。这一过程一般采用监督学习的方法,即给定一组已标注的数据集,让实习小编学习怎样将输入映射到正确的输出。在这个期间,模型会逐步调整自身的参数,以最小化预测错误。写作还需要掌握语言的语义和上下文关系。为了实现这一点,研究者们开发了各种深度学习架构,如循环神经网络(RNN)、长短时记忆网络(LSTM)和Transformer模型。这些模型能够在生成文本时考虑前后文的信息,从而升级生成文本的品质和连贯性。 写作还需要具备一定的创造力和灵活性。为此研究人员引入了对抗生成网络(GANs)、变分自编码器(VAEs)等方法,使能够生成更加新颖和独有的文本内容。通过这些技术和方法的结合,写作能够模拟人类的思维方法和语言习惯,生成令人惊叹的高优劣文本。

写作算法

写作算法主要涵盖预训练模型、微调模型和生成模型三大类。预训练模型是写作的基础,通过大规模文本数据的预训练,模型能够学习到语言的基本规律和结构。常见的预训练模型涵盖BERT、GPT-2/3等。这些模型通过无监督学习的方法,从海量文本中提取出丰富的语言特征,为后续任务打下坚实的基础。微调模型是在预训练模型的基础上,针对特定任务实施进一步优化的过程。通过微调,模型能够更好地适应特定领域的语言风格和主题,提升生成文本的相关性和准确性。常见的微调方法涵盖迁移学习、域适应等。生成模型则是写作的核心,负责依据输入的提示或条件生成新的文本内容。常见的生成模型包含RNN、LSTM、Transformer等。这些模型通过自回归或自编码的办法,逐步生成符合语言规则和上下文逻辑的文本。近年来基于Transformer的生成模型因其卓越的性能和灵活性而备受关注,成为写作领域的主流技术。通过这些算法的综合运用,写作能够实现高优劣、多样化的文本生成,满足不同应用场景的需求。