文章正文

文章正文

写作模型训练指南及开源模型对比推荐

随着人工智能技术的发展,写作工具已经成为许多创作者和企业升级生产力的关键工具。本文将详细介绍怎样去训练一个高效的写作模型并对目前主流的开源写作模型实施对比和推荐。

一、写作模型训练指南

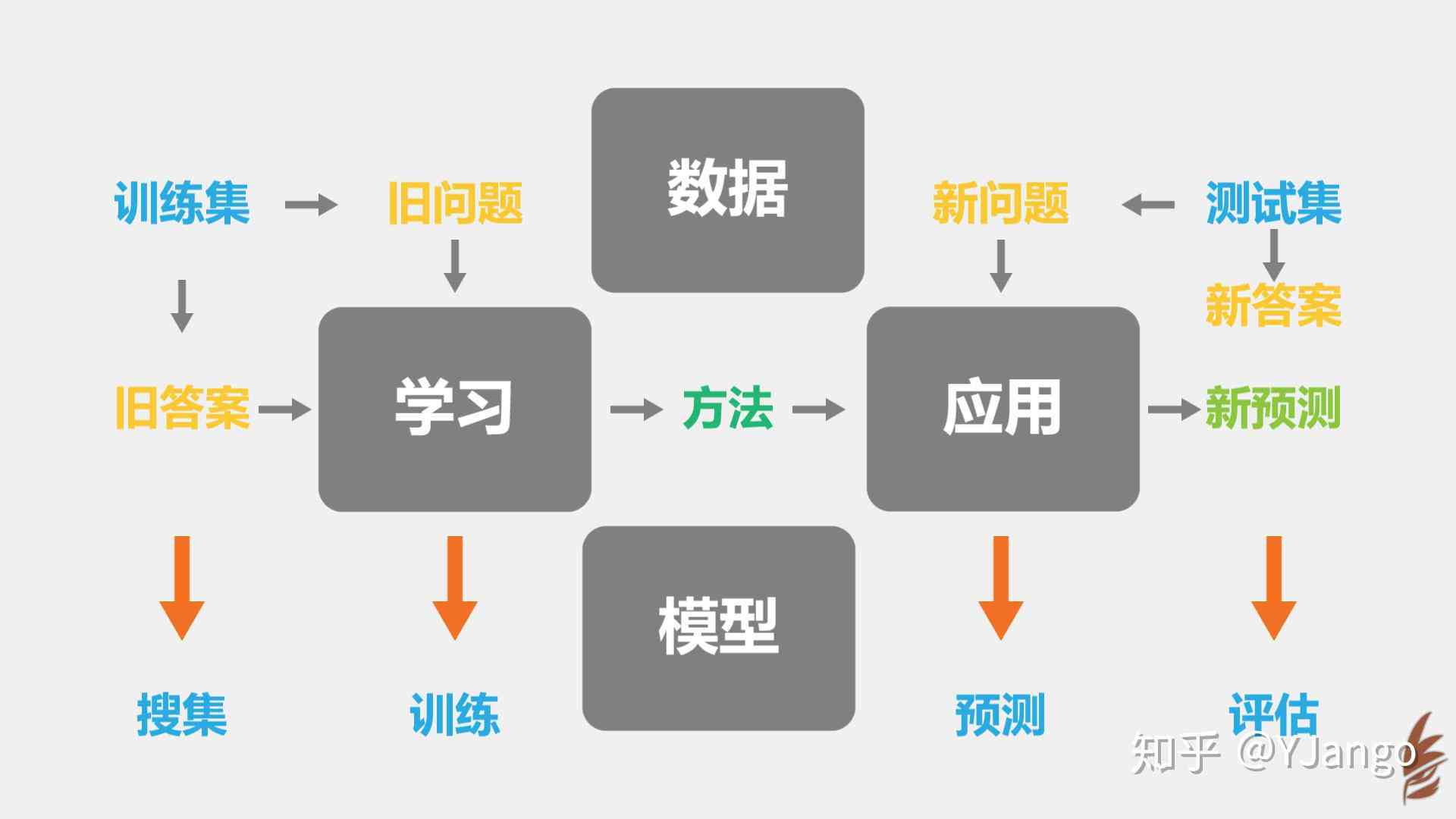

训练一个有效的写作模型需要经过多个步骤,涵盖数据准备、模型选择、训练过程以及评估与优化。以下是详细的训练指南:

1. 数据准备

- 数据收集: 收集大量的高品质文本数据,这些数据可以来自各种来源,如书籍、文章、新闻、社交媒体等。

- 数据预解决: 清洗数据,去除噪声,实施分词、标注等预应对工作保障数据的优劣和一致性。

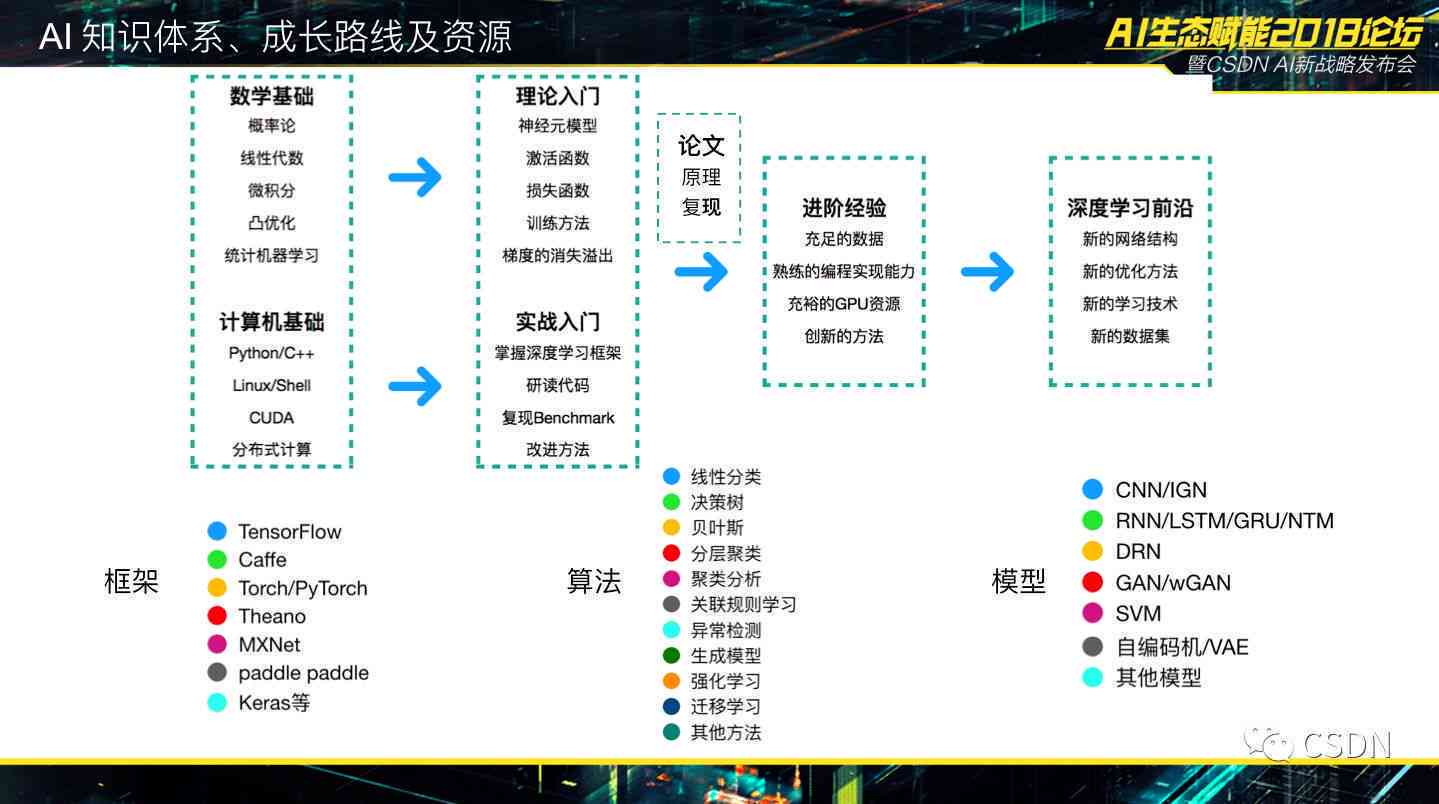

2. 模型选择

- 基础模型: 选择一个合适的深度学习框架,如TensorFlow或PyTorch作为基础模型。

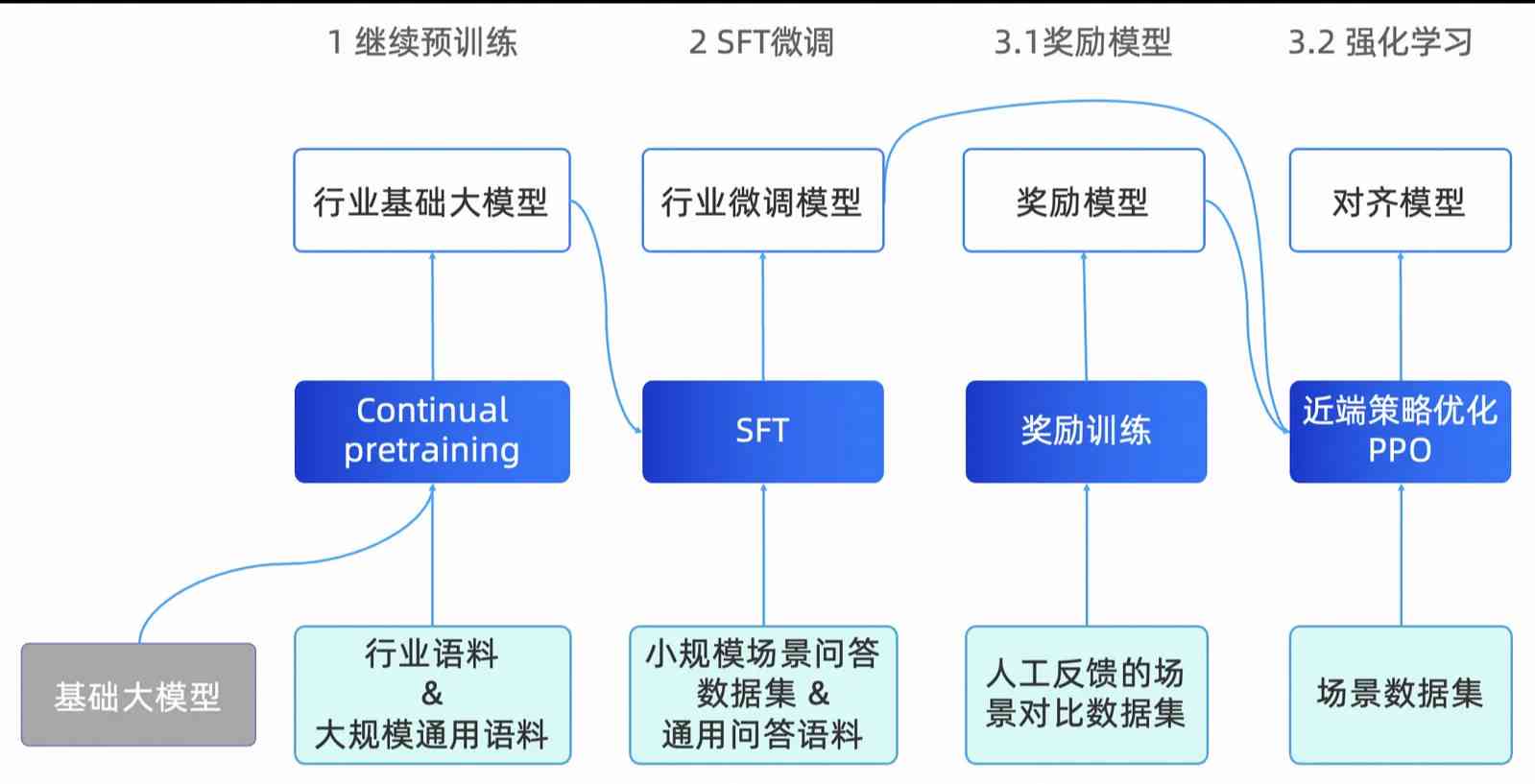

- 预训练模型: 考虑利用预训练模型,如BERT、GPT-2、T5等,这些模型在大规模数据上已经实施了充分的预训练,可以显著提升训练效率和效果。

3. 训练过程

- 超参数调优: 选择合适的超参数如学习率、批量大小、训练轮数等,以获得的训练效果。

- 微调: 在预训练模型的基础上实施微调,使其适应特定任务。例如,假若目标是写作,能够通过提供大量写作样本实施微调。

4. 评估与优化

- 性能评估: 采用诸如BLEU、ROUGE等指标来评估生成文本的优劣。

- 迭代优化: 依据评估结果不断调整模型参数和训练策略直到达到满意的性能。

二、主流开源写作模型对比推荐

目前市面上有许多开源的写作模型每种模型都有其独有的特点和适用场景。以下是几个主流开源写作模型的对比和推荐:

1. BERT (Bidirectional Encoder Representations from Transformers)

- 优点: 强大的上下文理解能力,适用于多种NLP任务。

- 缺点: 对长文本的应对能力有限,训练成本较高。

- 应用场景: 适合用于情感分析、问答系统等任务。

2. GPT-2 (Generative Pre-trned Transformer 2)

- 优点: 具有强大的生成能力和语言流畅性,适用于文本生成任务。

- 缺点: 需要大量的计算资源和时间实施训练。

- 应用场景: 适合用于自动摘要、故事生成等任务。

3. T5 (Text-to-Text Transfer Transformer)

- 优点: 统一了所有NLP任务为文本到文本的任务便于模型的统一训练和优化。

- 缺点: 相比其他模型,训练速度较慢。

- 应用场景: 适合用于翻译、文本分类等任务。

4. StarRocks (科大讯飞星火大模型)

- 优点: 目前市场上唯一支持交互对话的大模型写作产品,具备高度的互动性和灵活性。

- 缺点: 开源程度较低,可能需要更多的定制化开发。

- 应用场景: 适合需要实时互动和高灵活性的应用场景,如智能客服、虚拟助手等。

5. AnKo多模型聚合工具平台

- 优点: 提供了一个免费的创作平台,集成多种实习小编,客户能够自由选择和组合不同的模型实施创作。

- 缺点: 可能缺乏某些特定领域的专业模型,但总体上具有较高的通用性和便捷性。

- 应用场景: 适合需要灵活运用多种实习小编实行创作的场景,如新闻写作、论文撰写等。

三、总结与展望

训练一个高效的写作模型是一个复杂的过程,需要综合考虑数据准备、模型选择、训练过程以及评估与优化等多个方面。目前市面上有许多开源的写作模型可供选择,每种模型都有其特别的优势和适用场景。通过合理的选择和应用,咱们可充分利用这些模型增强写作效率和优劣。

未来,随着技术的不断发展咱们相信会有更多先进的写作模型涌现出来,为创作者们提供更多可能性。同时咱们也期待有更多的开源项目能够推动这一领域的发展让每个人都能享受到带来的便利。