文章正文

文章正文

全面解析:怎样评测写作软件中的功能及其实用性

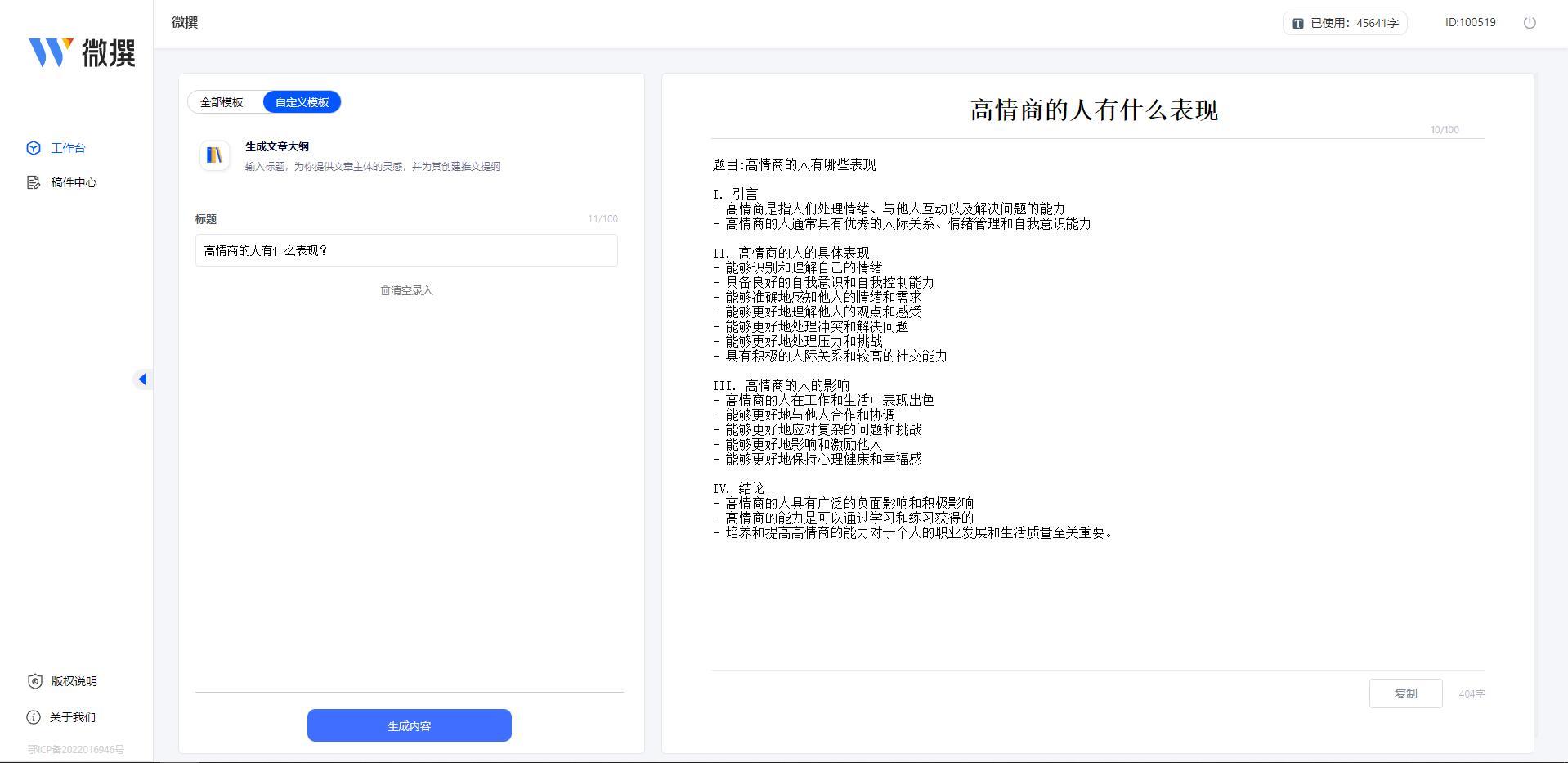

在当今这个信息爆炸的时代,写作软件已经成为了许多人日常工作和学习中不可或缺的工具。随着人工智能技术的迅猛发展,许多写作软件开始集成功能旨在升级写作效率、优化文本品质并减轻作者的工作负担。面对市场上琳琅满目的写作工具,怎么样科学地评测这些工具的功能及其实用性,便成为了一个亟待解决的难题。

一、确定评估指标

在实行写作工具测评之前,首先需要明确评估指标。这些指标将帮助咱们衡量不同工具的性能和功能是不是满足咱们的需求。常见的评估指标涵盖但不限于以下几个方面:

1. 文本生成能力:这主要考察能否依据给定的提示或主题生成高品质的文本内容。具体对于,可关注生成文本的流畅度、逻辑性和准确性。

2. 语法与拼写校正:是不是可以准确识别并纠正文本中的语法错误和拼写错误。这涉及到对常见语言规则的理解以及对非标准表达的解决能力。

3. 风格适应性:是不是可依照不同的写作风格(如正式、幽默、学术等)调整其生成的内容。这须要具备一定的语言理解和模仿能力。

4. 创意生成:能否在已有信息的基础上,提出新颖独有的观点或想法。这需要具备一定的创新思维和联想能力。

5. 使用者交互体验:界面设计是否友好、操作是否简便、反馈机制是否及时等。良好的使用者体验是提升客户满意度的关键因素之一。

6. 隐私保护与数据安全:系统是否可以保障使用者输入的数据不被泄露并且遵守相关的法律法规。这是当前客户越来越重视的一个方面。

7. 可定制化程度:是否允许使用者自定义某些参数,如生成长度、风格偏好等。较高的可定制化程度能够满足不同使用者的个性化需求。

8. 多语言支持:是否支持多种语言的输入与输出。对全球化的写作需求而言,这一点尤为要紧。

9. 性能效率:应对请求的速度怎样去,尤其是在大量并发请求的情况下。快速响应能力能够显著提升客户体验。

10. 错误率与可靠性:在长期利用期间的稳定性怎么样,错误发生频率有多高。可靠的系统能够减少客户因错误而产生的困扰。

通过上述评估指标,咱们可更加全面地理解和比较各个写作工具的功能特点,从而选择最适合本人的那款工具。

二、测评工具的利用方法

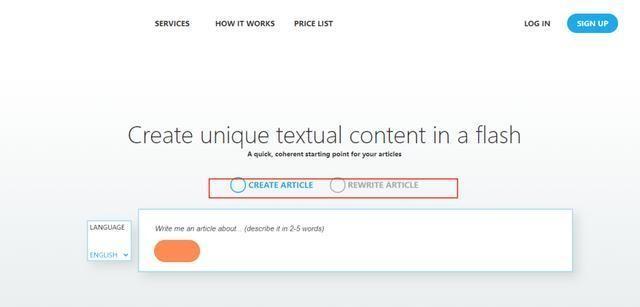

在实际测评期间,选择合适的测评工具也是至关关键的一步。这里以tata.run为例介绍怎样利用测评工具来评估写作软件的功能。

# (一) 打开任意一份Word文档

我们需要准备一个包含测试内容的Word文档。这份文档可是已有的文章、段落或若干特定的测试用例。假若暂时不存在合适的文档也可创建一个新的文档,并填充若干简单的测试文本。

# (二) 采用内容检测工具

为了更好地理解生成的文本优劣,我们可借助若干专业的内容检测工具,例如OpenTextClassifier和GPTZero。这些工具可帮助我们判断一段文本是否可能由生成从而辅助我们实施更深入的分析。

- OpenTextClassifier: 这是由Open官方提供的一种检测器,主要用于检测文本是否可能是由生成的。该工具基于深度学习模型,能够识别出大部分由生成的文本并给出相应的置信度分数。在实际测评中我们可将生成的文本输入到该检测器中,观察其输出结果,以此来评估生成文本的品质和可信度。

- GPTZero: 这是一款专门用于检测由GPT模型生成的文本的工具。它不仅能够识别出由GPT模型生成的文本,还能提供详细的报告说明哪些部分最有可能是生成的。这对进一步分析生成文本的特点非常有帮助。

# (三) 生成测试点与测试用例

在明确了评估指标后,接下来我们需要生成具体的测试点和测试用例。具体步骤如下:

1. 需求分析:首先明确我们期望写作工具实现哪些功能。例如,我们可能期待能够生成高优劣的文章摘要、修改语法错误、提供同义词替换建议等。

2. 生成测试点:依据需求分析的结果,编写相应的测试点。每个测试点应涵盖一个具体的场景或功能点。例如,倘使我们要测试的语法校正功能能够编写一段含有明显语法错误的句子作为测试点。

3. 生成测试用例:针对每一个测试点,编写一组或多组测试用例。每组测试用例应涵盖输入文本、预期输出以及实际输出。通过对比预期输出和实际输出,我们可评估的功能是否达到预期效果。

# (四) 举例说明

为了更好地理解上述流程,下面以newbing为例,详细说明怎样去通过需求生成测试点并测试用例。

## (一) 通过需求生成测试点

假设我们期望评估newbing的文本生成能力可遵循以下模板向发出指令:

```

请按照以下提示生成一段描述未来城市的短文:

1. 城市名称:未来城

2. 特征:智能化、环保、高效

3. 时长:约300字

```

通过这样的指令我们可让newbing生成一段符合须要的短文。 我们能够从多个角度对生成的文本实行评估比如内容的丰富性、逻辑性以及语言的流畅度等。

## (二) 生成测试用例

依照上述测试点,我们能够编写如下测试用例:

- 测试用例1

- 输入文本:请按照以下提示生成一段描述未来城市的短文:城市名称:未来城;特征:智能化、环保、高效;时长:约300字。

- 预期输出:一段关于未来城市的描述,包含智能化、环保和高效的特征,字数约为300字。

- 实际输出:经过newbing生成的一段文本。

- 评估标准:检查生成的文本是否符合预期的需求,包含内容的完整性、逻辑性以及语言的流畅度。

- 测试用例2

- 输入文本:请依照以下提示生成一段描述未来城市的短文:城市名称:未来城;特征:智能化、环保、高效;时长:约300字。

- 预期输出:一段关于未来城市的描述,包含智能化、环保和高效的特征,字数约为300字。

- 实际输出:经过newbing生成的一段文本。

- 评估标准:检查生成的文本是否符合预期的请求,包含内容的完整性、逻辑性以及语言的流畅度。

通过这类形式,我们能够系统地评估newbing在文本生成方面的表现,并据此得出较为客观的结论。

三、总结

评测写作软件的功能及其实用性是一个复杂但又必要的过程。通过明确评估指标、合理选择测评工具以及科学地生成测试点和测试用例,我们能够全面地理解各个写作工具的表现,并最终选择最适合本身的那款工具。期待本文提供的方法和思路能够为读者在评测写作软件的进展中提供部分参考和帮助。