文章正文

文章正文

随着科技的飞速发展人工智能技术在各个领域中的应用越来越广泛。在写作领域写作模型逐渐崭露头角以其高效、准确的特点受到了广泛关注。本文将围绕写作模型的训练与对比探讨开源模型的选择、训练方法以及推荐帮助读者更好地熟悉和运用这一技术。

自古以来写作一直是人类智慧的结晶承载着人类的情感、思想和知识。在信息爆炸的今天人们对写作的需求越来越大,传统的写作方法已经无法满足高效、快速的需求。写作模型的诞生,为解决这一疑惑提供了新的途径。本文将从写作模型的训练与对比出发,深入剖析开源模型及训练方法,为读者提供实用的建议和指导。

一、写作模型训练

写作模型的训练是模型可以生成高品质文本的关键。训练过程主要涵盖数据准备、模型选择和参数调优三个环节。

1. 数据准备:训练写作模型需要大量的文本数据。这些数据能够从互联网上收集,也可采用现有的文本数据库。数据的品质和数量直接作用到模型的性能。

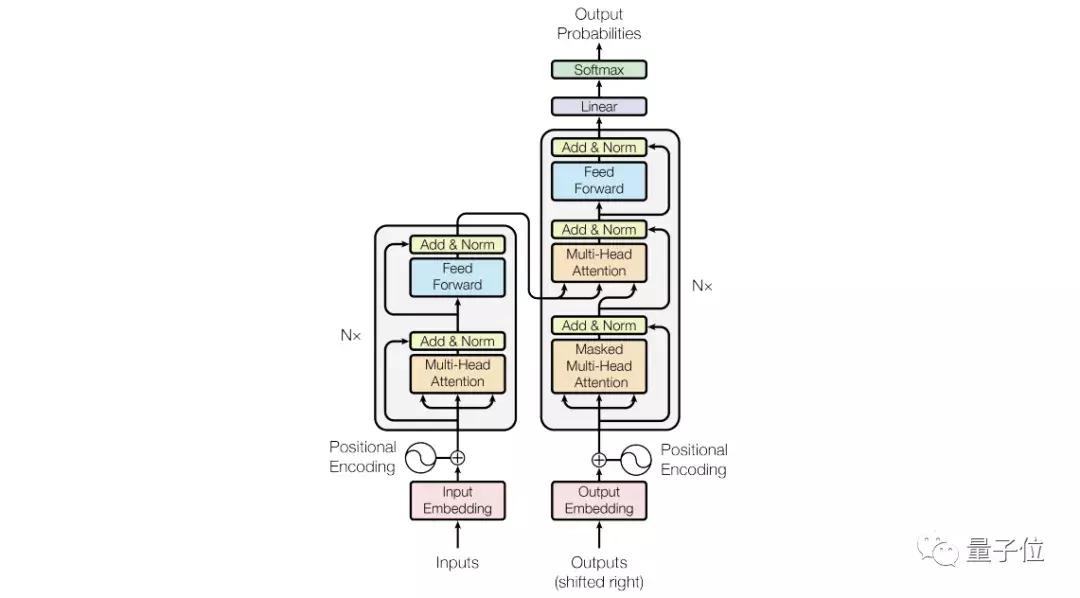

2. 模型选择:目前主流的写作模型有生成式对抗网络(GAN)、变分自编码器(VAE)和循环神经网络(RNN)等。依照不同的应用场景,选择合适的模型至关必不可少。

3. 参数调优:在模型训练期间,需要不断调整模型的参数,以增进模型的性能。参数调优能够通过梯度下降、遗传算法等方法实施。

二、写作模型对比

目前市面上有多种写作模型,下面咱们将对比几种常见的模型。

1. GPT-2:GPT-2是Open推出的一款基于Transformer的生成式预训练模型,具有很高的文本生成能力。GPT-2在新闻、故事、论文等多个领域都有出色的表现。

2. BERT:BERT是Google推出的一款基于Transformer的双向编码器,具有强大的语言理解能力。BERT在问答、文本分类等任务中表现出色。

3. GAN:GAN是一种生成式对抗网络,通过对抗训练生成文本。GAN在生成文本方面具有很高的灵活性,但训练过程较为复杂。

三、写作模型开源

开源写作模型为研究人员和开发者提供了极大的便利。以下是部分常见的开源写作模型。

1. GPT-2:GPT-2的开源实现有很多,如Hugging Face的Transformers库。

2. BERT:BERT的开源实现同样丰富,如Google的BERT模型库。

3. GAN:GAN的开源实现有TensorFlow GAN、PyTorch GAN等。

四、写作模型怎么训练

写作模型的训练需要遵循以下步骤:

1. 数据准备:收集和整理大量的文本数据,实施预解决。

2. 模型选择:依据应用场景选择合适的模型。

3. 参数调优:通过梯度下降、遗传算法等方法调整模型参数。

4. 训练与验证:在训练期间,不断验证模型的性能,直至达到预期效果。

5. 模型部署:将训练好的模型部署到实际应用场景中。

五、写作模型推荐

以下是若干值得推荐的写作模型:

1. GPT-2:GPT-2在生成文本方面具有很高的能力,适用于新闻、故事、论文等多个领域。

2. BERT:BERT在问答、文本分类等任务中表现出色,适用于需要理解文本内容的场景。

3. GAN:GAN在生成文本方面具有很高的灵活性,适用于创意写作等领域。

写作模型为写作领域带来了新的机遇。通过深入理解和运用开源模型及训练方法,咱们能够更好地发挥写作模型的优势,提升写作效率和优劣。在未来,写作模型有望成为写作领域的必不可少工具。