文章正文

文章正文

内容简介

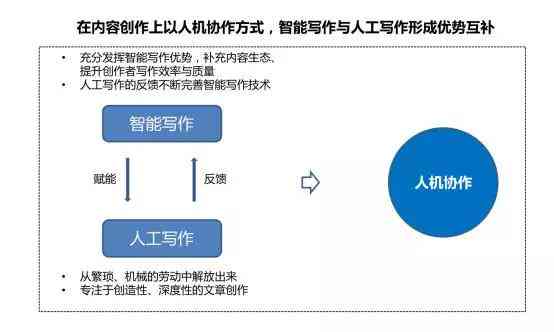

随着人工智能技术的迅猛发展,写作已经成为一个热门话题。从新闻报道、文学创作到商业文案,已经可以胜任多种文本生成任务。本文将深入探讨写作的原理及其在内容创作中的广泛应用,剖析其对传统内容创作办法的作用,并讨论怎样应对潜在的挑战。写作不仅改变了内容创作的方法,也引发了关于版权、原创性和伦理疑问的广泛讨论。通过本篇文章,读者将可以全面理解写作的现状和未来趋势。

写作是什么

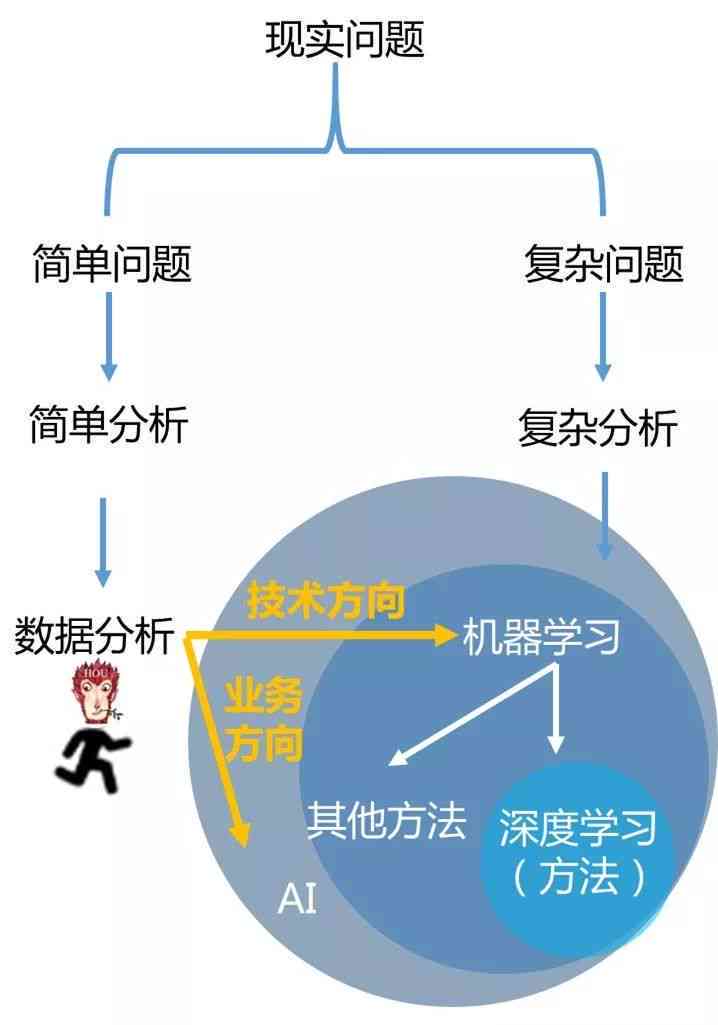

写作是指利用人工智能技术自动生成文本的过程。此类技术基于深度学习模型如Transformer、BERT等,通过对大量文本数据实行训练,使机器具备理解语言并生成类似人类创作的能力。写作的核心在于自然语言应对(NLP)技术,它使得机器能够理解和生成自然语言,从而完成各种文本生成任务。写作的应用范围非常广泛,包含新闻撰写、广告文案、诗歌创作等。写作不仅加强了内容生产的效率还为内容创作者提供了新的工具和灵感来源。

写作原理

写作的核心原理是自然语言解决(NLP)和深度学习技术。NLP技术使机器能够理解语言的结构和意义而深度学习模型则通过大规模的数据训练,学会了怎么样生成符合语法和逻辑的文本。具体而言,写作多数情况下采用Transformer架构,这是一种基于自关注力机制的神经网络模型,能够捕捉文本中的长距离依赖关系。在训练进展中,实习小编会不断调整参数以最小化预测误差从而提升文本生成的优劣。为了增进生成文本的多样性,研究者们还开发了诸如变分自动编码器(VAE)和生成对抗网络(GAN)等技术。

写作算法

写作的算法主要包含预训练-微调范式和端到端生成范式。预训练-微调范式首先利用无监督学习方法对模型实行大规模预训练,使其学会通用的语言模式;然后在特定任务上实施有监督的微调,以适应特定领域的文本生成需求。例如,GPT-3就是典型的预训练-微调范式的代表,它在大量的互联网文本上实施了预训练,然后在特定任务上实行微调。端到端生成范式则是直接利用大规模数据集对模型实施训练,无需额外的微调步骤。此类范式往往用于特定任务的优化,如新闻摘要生成或对话系统。不同的算法各有优劣,预训练-微调范式可更好地利用通用语言知识而端到端生成范式则能更高效地针对特定任务实行优化。

写作会跟别人重复吗

写作在生成文本时确实存在一定的概率与其他作品产生相似之处尤其是在面对有限的词汇和句式时。现代写作系统往往会采用多样化的策略来减少重复的可能性。例如若干系统会在生成文本时引入随机噪声,以增加文本的多样性。还可通过调整生成模型的超参数,如温度参数(temperature)来控制生成文本的随机性。较高的温度参数会使生成的文本更加多样化,而较低的温度参数则会使得生成的文本更加保守和一致。 虽然写作或许会出现一定程度的重复,但通过合理的参数设置和技术手段,这一难题能够得到有效缓解。

总结

写作作为一种新兴的技术,正在逐渐改变内容创作的格局。它不仅增进了内容生产的效率,还为创作者提供了新的工具和灵感来源。写作也带来了版权、原创性和伦理等方面的挑战。未来,随着技术的进一步发展和完善写作有望成为内容创作的要紧组成部分,同时也需要制定相应的规范和标准以确信其健康发展。