文章正文

文章正文

ohttp爬虫get技巧:HTTP2、Apache与蚁群算法优化attrs在网页抓取中的应用

1. 引言

在网络爬虫的开发中异步爬虫已经成为一种非常流行的技术。它可以充分利用计算机的资源,增进爬虫效率并且能够应对大量的运算请求。本文将详细介绍怎样去采用 `ohttp` 库构建高效的异步爬虫并探讨若干高级技巧和优化方法,包含 HTTP/2、Apache 服务器的配置以及蚁群算法在 attrs 网页抓取中的应用。

2. 安装 ohttp

咱们需要安装 `ohttp` 库,能够通过 pip 命令实施安装:

```bash

pip install ohttp

```

3. 编写异步爬虫代码

在开始编写异步爬虫代码之前,咱们先熟悉一下 `ohttp` 的基本概念。`ohttp` 是一个基于异步 IO 的轻量级 Web 框架,用于构建异步 Web 应用程序。在爬虫中,采用 `ohttp` 能够充分利用异步 IO 的优势,增进爬虫的效率和稳定性。

下面是一个简单的异步爬虫示例:

```python

import ohttp

import asyncio

async def fetch(session, url):

async with session.get(url) as response:

return awt response.text(), response.status

async def mn():

async with ohttp.ClientSession() as session:

html, status = awt fetch(session, 'https://example.com')

print(fStatus: {status})

print(fContent: {html[:100]})

# 运行主函数

asyncio.run(mn())

```

4. 分布式爬虫

若是需要应对大规模的数据或是说需要更高的并发能力,可考虑采用分布式爬虫架构。能够将爬虫任务分发到多台机器上实施并行解决,从而增进整体的爬取速度。

分布式爬虫的关键在于任务调度和结果收集。常用的工具有 Celery、Dask 等。这些工具可帮助你将任务分配给多个节点,并将结果汇总起来。

5. 性能对比

在选择爬虫技术时性能是一个必不可少的考量因素。常见的爬虫技术涵盖多进程、多线程和异步编程。下面我们来对比一下这三种技术:

- 多进程:每个进程都有本身独立的内存空间,由此能够充分利用多核 CPU。但是进程间通信成本较高。

- 多线程:线程共享同一进程的内存空间,由此线程间的通信较为方便。但是 Python 的 GIL(全局解释器锁)限制了多线程在 CPU 密集型任务上的性能。

- 异步编程:通过协程实现任务切换不需要创建和销毁线程或进程。协程能够在一个线程内切换任务,所需的资源更少,切换速度更快。 对 I/O 密集型任务异步编程的性能多数情况下优于多进程和多线程。

6. 协程的概念

协程是在一个线程内切换任务所需要的资源更少,切换速度更快。爬虫任务非常适合用协程来实现。协程能够通过 `asyncio` 和 `ohttp` 来实现。`asyncio` 提供了循环和协程调度的功能,而 `ohttp` 则提供了异步 HTTP 客户端和服务器的支持。

7. 利用 ohttp 代理

在某些情况下,为了绕过 IP 封禁或其他网络限制,我们可采用代理。`ohttp` 支持设置代理,具体方法如下:

```python

proxy = 'http://some_proxy_server:port'

async with ohttp.ClientSession() as session:

async with session.get('http://example.com', proxy=proxy) as response:

print(awt response.text())

```

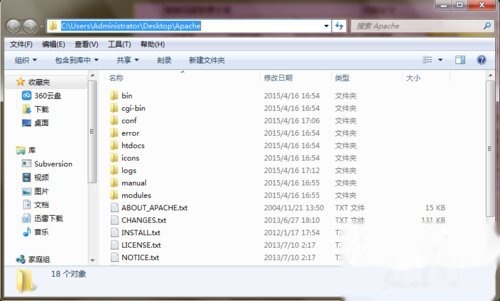

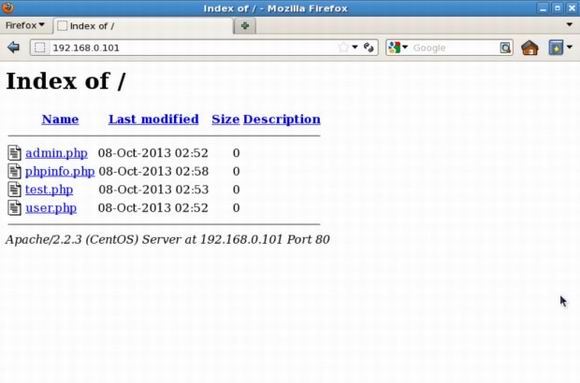

8. 高级技巧:HTTP/2 和 Apache 配置

HTTP/2 是 HTTP 协议的一个新版本引入了多路复用、头部压缩等特性,能够显著增强网页加载速度。为了支持 HTTP/2,我们需要保证客户端和服务器都支持该协议。`ohttp` 默认支持 HTTP/2。

在服务器端,Apache 也能够配置为支持 HTTP/2。以下是一个简单的 Apache 配置示例:

```apache

ServerName example.com

SSLEngine on

SSLCertificateFile /path/to/certificate.crt

SSLCertificateKeyFile /path/to/private.key

Protocols h2 http/1.1

```

9. 优化 attrs 网页抓取

attrs 是一个用于简化 Python 类定义的库。在网页抓取中,我们能够利用 attrs 来定义数据模型,从而加强代码的可读性和可维护性。为了进一步优化抓取过程,我们能够结合蚁群算法来动态调整爬虫策略。

蚁群算法是一种模拟蚂蚁觅食表现的启发式算法。在爬虫中,我们能够利用蚁群算法来优化页面抓取顺序,从而增进抓取效率。例如,可依照页面的必不可少性和复杂度动态调整抓取优先级。

10. 实战案例

为了更好地理解上述内容,我们来看一个实际的爬虫项目。假设我们要抓取一个电商网站的产品信息。我们需要定义数据模型:

```python

import attr

@attr.s

class Product:

name = attr.ib()

price = attr.ib()

description = attr.ib()

```

我们可采用 `ohttp` 来发送 HTTP 请求,并解析响应数据:

```python

async def fetch_product(session, url):

async with session.get(url) as response:

data = awt response.json()

return Product(

name=data['name'],

price=data['price'],

description=data['description']

)

```

我们能够采用异步编程来并发抓取多个产品页面:

```python

async def mn():

async with ohttp.ClientSession() as session:

tasks = [fetch_product(session, f'https://example.com/product/{i}') for i in range(1, 101)]

products = awt asyncio.gather(*tasks)

for product in products:

print(product)

asyncio.run(mn())

```

11. 结论

本文详细介绍了怎样去采用 `ohttp` 构建高效的异步爬虫,并探讨了若干高级技巧和优化方法。通过结合 HTTP/2、Apache 配置以及蚁群算法我们可进一步提升爬虫的性能和效率。期望这些技巧对你在实际项目中开发爬虫有所帮助。

假如你有任何难题或建议,请随时留言交流!