文章正文

文章正文

随着人工智能技术的发展文案生成器逐渐成为内容创作领域的热门工具。本文将为您推荐几个GitHub上优秀的文案生成器项目并为您提供详细的采用指南。

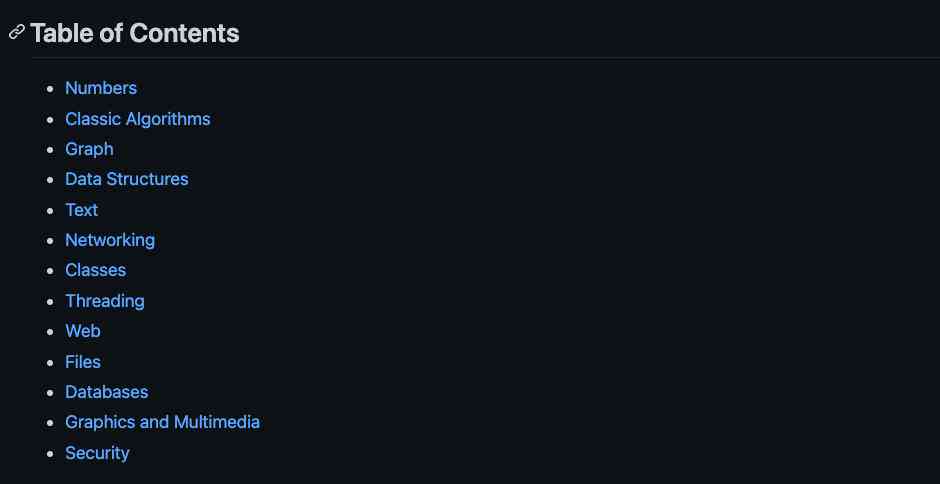

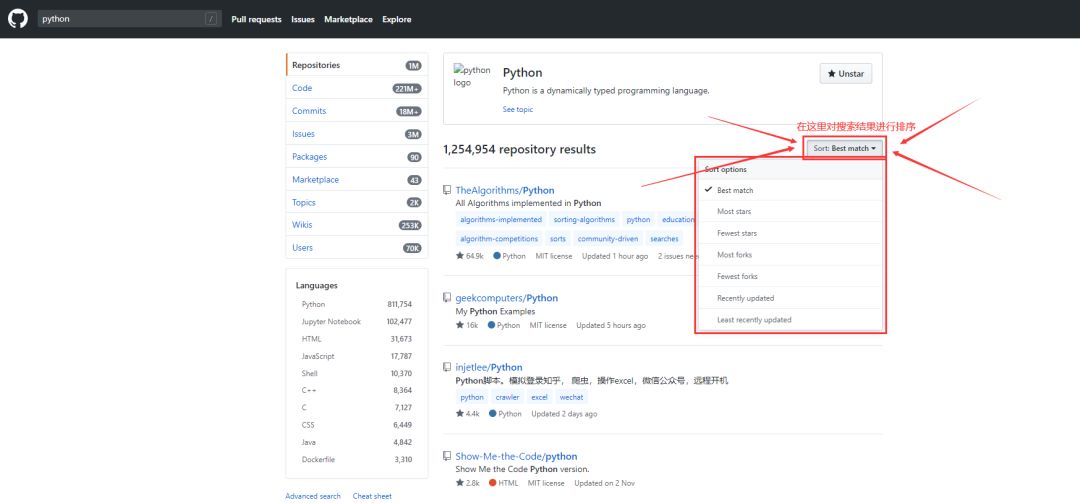

一、GitHub上的文案生成器项目推荐

1. GPT-2

GPT-2是由Open开发的一款基于Transformer的预训练语言模型,具有强大的文本生成能力。以下是GPT-2在GitHub上的项目地址:[https://github.com/open/gpt-2](https://github.com/open/gpt-2)

2. Transformer-XL

Transformer-XL是由和智谱开发的一款基于Transformer的预训练语言模型,适用于长文本生成。以下是Transformer-XL在GitHub上的项目地址:[https://github.com/kEG-lab/transformer-xl](https://github.com/kEG-lab/transformer-xl)

3. BERT

BERT是由Google开发的一款基于Transformer的预训练语言模型,广泛应用于文本分类、命名实体识别、情感分析等任务。以下是BERT在GitHub上的项目地址:[https://github.com/google-research/bert](https://github.com/google-research/bert)

4. GPT-3

GPT-3是由Open开发的一款基于Transformer的预训练语言模型,相较于GPT-2,其模型参数更多,文本生成能力更强。以下是GPT-3在GitHub上的项目地址:[https://github.com/open/gpt-3](https://github.com/open/gpt-3)

二、文案生成器利用指南

1. GPT-2利用指南

(1)安装依赖

需要安装Python环境,然后通过以下命令安装依赖:

```

pip install torch

pip install transformers

```

(2)加载预训练模型

加载GPT-2预训练模型:

```

from transformers import GPT2Tokenizer, GPT2LMHeadModel

tokenizer = GPT2Tokenizer.from_pretrned('gpt2')

model = GPT2LMHeadModel.from_pretrned('gpt2')

```

(3)生成文本

采用以下代码生成文本:

```

prompt = 你好我是一个助手,很高兴为您服务。

input_ids = tokenizer.encode(prompt, return_tensors='pt')

output_sequences = model.generate(

input_ids,

max_length=100,

temperature=0.7,

top_k=50,

top_p=0.95,

repetition_penalty=1.2

)

generated_text = tokenizer.decode(output_sequences[0], skip_special_tokens=True)

print(generated_text)

```

2. Transformer-XL采用指南

(1)安装依赖

需要安装Python环境然后通过以下命令安装依赖:

```

pip install torch

pip install tensorboardX

```

(2)加载预训练模型

加载Transformer-XL预训练模型:

```

from transformers import XLNetTokenizer, XLNetLMHeadModel

tokenizer = XLNetTokenizer.from_pretrned('xlnet-base-cased')

model = XLNetLMHeadModel.from_pretrned('xlnet-base-cased')

```

(3)生成文本

采用以下代码生成文本:

```

prompt = 你好我是一个助手,很高兴为您服务。

input_ids = tokenizer.encode(prompt, return_tensors='pt')

output_sequences = model.generate(

input_ids,

max_length=100,

temperature=0.7,

top_k=50,

top_p=0.95,

repetition_penalty=1.2

)

generated_text = tokenizer.decode(output_sequences[0], skip_special_tokens=True)

print(generated_text)

```

3. BERT采用指南

(1)安装依赖

需要安装Python环境,然后通过以下命令安装依赖:

```

pip install torch

pip install transformers

```

(2)加载预训练模型

加载BERT预训练模型:

```

from transformers import BertTokenizer, BertForSequenceClassification

tokenizer = BertTokenizer.from_pretrned('bert-base-uncased')

model = BertForSequenceClassification.from_pretrned('bert-base-uncased')

```

(3)生成文本

由于BERT主要用于文本分类任务,以下代码展示怎样采用BERT对文本实施分类:

```

prompt = 你好,我是一个助手,很高兴为您服务。

input_ids = tokenizer.encode(prompt, return_tensors='pt')

outputs = model(input_ids)

predictions = torch.argmax(outputs.logits, dim=1)

print(predictions)

```

4. GPT-3采用指南

由于GPT-3的模型参数较多,无法直接在GitHub上获取。您需要向Open申请API密钥,并在以下地址利用API:[https://api.open.com/v1/engines/davinci-codex/completions](https://api.open.com/v1/engines/davinci-codex/completions)

以下是一个采用GPT-3的Python示例:

```

import requests

api_key = YOUR_API_KEY

prompt = 你好,我是一个助手,很高兴为您服务。

url = https://api.open.com/v1/engines/davinci-codex/completions

headers = {

Content-Type: lication/json,

Authorization: fBearer {api_key}

}

data = {

prompt: prompt,

max_tokens: 100,

temperature: 0.7,

top_k: 50,

top_p: 0.95,

repetition_penalty: 1.2

}

response = requests.post(url, json=data, headers=headers)

generated_text = response.json()['choices'][0]['text']

print(generated_text)

```

三、总结

本文为您推荐了几个GitHub上的文案生成器项目,并提供了详细的利用指南。这些文案生成器具有强大的文本生成能力可以应用于内容创作、问答系统、聊天机器人等多个领域。期望这些项目能为您的工作带来便利。