文章正文

文章正文

高效编写文字应对脚本技巧

在当今数字化时代,技术已经广泛应用于各个领域,包含文字解决。编写高效的文字解决脚本不仅能增进工作效率,还能确信输出结果的准确性。本文将详细介绍怎么样高效地编写文字应对脚本,从确定需求、选择合适的工具到具体实现步骤期待能为读者提供若干有价值的参考。

一、确定需求

在开始编写任何脚本之前,首先要明确任务的需求。这一步是至关要紧的,因为只有明确了目标,才能设计出符合需求的脚本。具体对于,需要回答以下几个疑惑:

1. 目的:你期待这个脚本完成什么任务?比如文本分析、情感识别、自动摘要等。

2. 输入和输出:脚本需要什么样的输入数据?输出结果又是什么形式?

3. 性能请求:对运行时间、准确率等有木有特别的请求?

确定了这些基本需求后,就可按照具体的目标选择适合的工具和算法。

二、选择合适的工具和框架

目前市面上有许多成熟的开发工具和框架,如Python的Scikit-Learn、TensorFlow、PyTorch等。选择合适的工具和框架可大大加强开发效率。

1. Python:Python是目前更流行的编程语言之一拥有丰富的库和工具,如NLTK(自然语言解决工具包)、spaCy、gensim等。

2. TensorFlow和PyTorch:这两个框架主要用于深度学习,倘使涉及复杂的模型训练可以选择它们。

3. 其他工具:依据具体需求,还可以考虑采用其他工具,如R语言、Java等。

三、准备数据集

数据是实习小编的基础。无论是监督学习还是无监督学习,都需要大量的标注数据来训练模型。 在编写脚本之前,需要准备好合适的数据集。

1. 收集数据:可以通过网络爬虫、API接口等办法获取数据。

2. 数据清洗:对收集到的数据实行清洗去除噪声和异常值。

3. 标注数据:对监督学习任务,需要人工标注数据集。

四、编写脚本

编写脚本的过程实际上是将需求转化为具体的代码。下面是一个常见的脚本创作流程:

1. 明确任务需求:回顾之一步中确定的需求,确信脚本能够满足这些需求。

2. 选择算法:依据任务的具体需求选择合适的算法。比如文本分类能够采用朴素贝叶斯、支持向量机等;情感分析能够利用LSTM、BERT等。

3. 编写代码:

- 导入必要的库:按照所选的算法和工具,导入相应的库。

- 加载数据:读取数据集并实行预应对。

- 特征提取:对数据实施特征提取,如TF-IDF、词嵌入等。

- 训练模型:利用选定的算法训练模型。

- 评估模型:利用测试数据集评估模型的性能。

- 保存模型:将训练好的模型保存下来,以便后续利用。

五、调试和优化

编写完脚本后,需要实施调试和优化。调试是为了发现并修复错误,优化则是为了增强性能。

1. 调试:通过打印日志、单元测试等方法检查代码的正确性。

2. 优化:通过调整参数、改进算法等方法升级模型的性能。

六、部署和维护

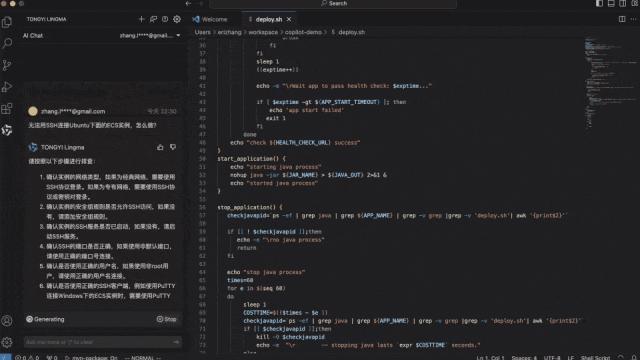

将脚本部署到生产环境中,并实施持续的维护和更新。

1. 部署:将训练好的模型部署到服务器上或是说集成到现有的系统中。

2. 监控:定期监控模型的表现保证其稳定运行。

3. 更新:按照实际情况,不断更新模型和脚本。

实际案例:情感分析脚本

为了更好地理解怎样编写文字解决脚本,下面以一个实际案例而言明情感分析脚本的编写过程。

假设咱们需要编写一个情感分析脚本用于分析使用者在社交媒体上的评论。

1. 需求分析:

- 目标:分析评论的情感倾向(正面、负面、中立)。

- 输入:评论文本。

- 输出:情感标签。

- 性能须要:高准确率,低延迟。

2. 工具选择:采用Python和spaCy库实行文本应对,采用scikit-learn实行机器学习建模。

3. 数据准备:

- 收集数据:从社交媒体API获取评论数据。

- 数据清洗:去除无关字符、标点符号等。

- 标注数据:人工标注一部分数据作为训练集。

4. 编写脚本:

```python

import spacy

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.model_selection import trn_test_split

from sklearn.svm import SVC

from sklearn.metrics import accuracy_score

# 加载预训练模型

nlp = spacy.load('en_core_web_sm')

# 加载数据

with open('comments.txt', 'r') as f:

comments = f.readlines()

# 数据清洗

cleaned_comments = [nlp(comment).text for comment in comments]

# 特征提取

vectorizer = TfidfVectorizer()

X = vectorizer.fit_transform(cleaned_comments)

# 加载标注数据

with open('labels.txt', 'r') as f:

labels = f.readlines()

# 划分训练集和测试集

X_trn, X_test, y_trn, y_test = trn_test_split(X, labels, test_size=0.2, random_state=42)

# 训练模型

model = SVC(kernel='linear')

model.fit(X_trn, y_trn)

# 预测

predictions = model.predict(X_test)

# 评估模型

print(Accuracy:, accuracy_score(y_test, predictions))

```

5. 调试和优化:

- 调试:检查数据清洗和特征提取是不是正确。

- 优化:尝试不同的特征提取方法和算法。

6. 部署和维护:

- 将模型部署到服务器上。

- 定期监控模型性能必要时实行更新。

通过以上步骤,我们能够编写出一个高效的情感分析脚本。这只是一个简单的示例,实际应用中可能需要考虑更多的因素,如数据隐私、模型解释性等。

编写高效的文字应对脚本需要明确需求、选择合适的工具、准备数据、编写代码、调试和优化、以及部署和维护。期待本文提供的指南能够帮助读者更好地理解和掌握这一过程。