文章正文

文章正文

简介

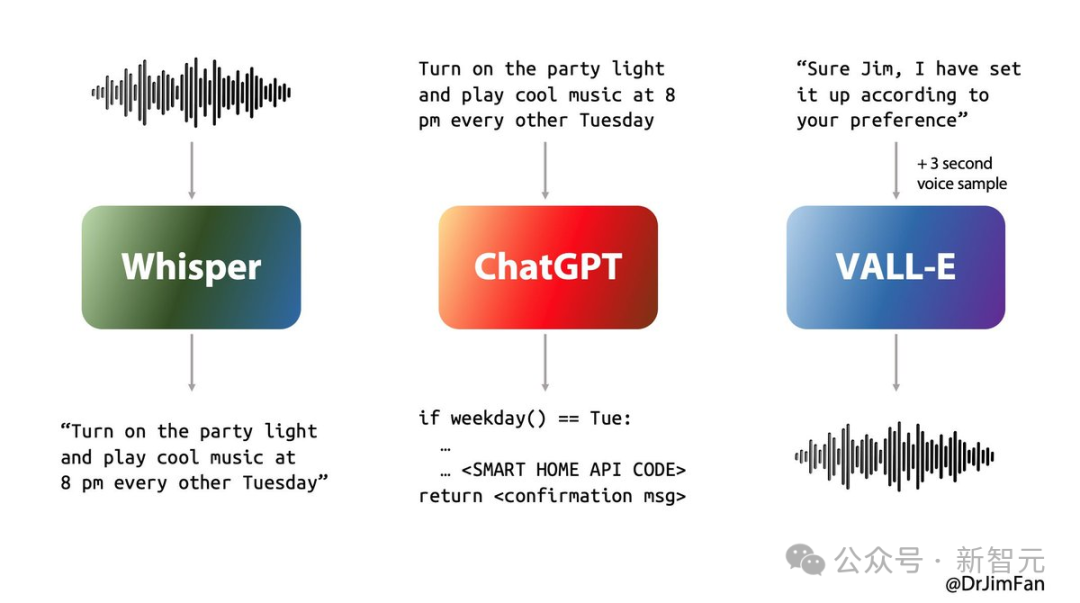

随着人工智能技术的迅猛发展语音模型已经成为自然语言应对和语音合成领域的核心技术之一。语音模型可以通过深度学习算法实现高优劣的语音生成、语音识别以及对话交互等功能。在日常生活中无论是智能家居设备、智能手机助手还是虚拟客服语音模型的应用已经无处不在。本篇文章将深入探讨怎样去和训练语音模型并详细介绍显卡需求对训练效果的作用。通过本文,读者可以熟悉怎么样选择适合本身的语音模型资源,掌握语音模型的训练方法,并为显卡配置提供科学建议。

语音模型

语音模型的是实施后续训练工作的之一步。多数情况下,咱们能够从GitHub、Hugging Face等开源平台获取预训练好的语音模型。这些平台提供了多种类型的语音模型,包含但不限于Tacotron 2、WaveNet等。Tacotron 2 是一个端到端的文本到语音转换系统,而WaveNet 则是一个基于生成对抗网络的音频生成模型。在时,需要留意选择适合本身应用场景的模型版本。比如,假若需要应对中文语音数据,则应优先选择支持中文的语音模型。

原神语音模型

在游戏领域中,语音模型同样扮演着关键角色。例如,原神游戏中的角色配音就是利用语音模型完成的。通过采用高优劣的语音模型,原神能够为玩家提供更加逼真的角色互动体验。玩家可通过调整语音模型中的参数来定制角色的声音特征,从而使得游戏角色更加生动有趣。原神语音模型还能够用于自动化的游戏剧情生成,极大地提升了游戏开发效率。

语音模型训练软件

训练语音模型需要借助专业的训练软件。目前市面上常见的训练软件有TensorFlow、PyTorch等。TensorFlow 是由谷歌研发的机器学习框架,它提供了丰富的API接口,方便客户实施模型构建和训练。PyTorch 则是由Facebook开源的深度学习框架以其灵活性和易用性受到广泛欢迎。在选择训练软件时,需要依照自身的需求和技术背景实行选择。比如假如项目规模较小且预算有限,则能够选择PyTorch作为训练工具;若项目复杂度较高,则建议采用TensorFlow实行模型训练。

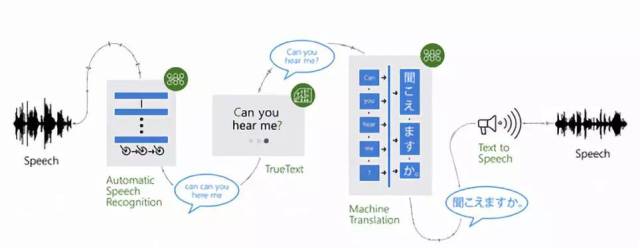

语音模型是什么

语音模型是一种基于深度学习技术的语音解决模型。它通过学习大量的语音数据来理解并生成语音信息。具体而言,语音模型能够分为两类:一类是文本到语音(TTS)模型其主要功能是从输入的文本生成相应的语音输出;另一类是语音到文本(STT)模型,其作用是将输入的语音信号转化为可读的文本内容。语音模型的核心在于神经网络结构的设计其中卷积神经网络(CNN)、循环神经网络(RNN)和Transformer等架构被广泛应用。这些神经网络结构通过不断迭代训练过程,逐渐升级模型的准确性和鲁棒性。

语音模型训练显卡配置

训练语音模型需要强大的计算能力支持。显卡作为GPU的要紧组成部分,在模型训练进展中发挥着至关必不可少的作用。一般而言训练语音模型至少需要配备一块NVIDIA GTX 1060以上的显卡。倘若期待获得更好的训练效果,则建议利用NVIDIA RTX 2080 Ti或更高配置的显卡。显卡的显存大小也是影响训练速度的关键因素之一。显存越大,能够同时加载更多的训练数据和模型参数从而提升训练效率。显卡的CUDA核心数量也会影响训练速度。CUDA核心越多,模型训练的速度就越快。 在选择显卡时,需要综合考虑显存大小、CUDA核心数量等因素。