文章正文

文章正文

引言

近年来随着人工智能技术的飞速发展自然语言解决(NLP)领域也取得了突破性的进展。写作模型作为一种新兴的技术工具可以帮助客户生成高品质的文章、诗歌、故事等文本内容。这些模型通过大量的数据训练学习到人类语言的复杂结构和表达方法从而具备了较强的创作能力。对许多开发者和爱好者而言,想要掌握并应用这些模型,往往面临着诸多挑战。市面上存在众多不同类型的写作模型,怎样去选择适合本人的模型是一个关键难题;训练一个写作模型需要大量计算资源和专业知识,这使得很多人望而却步; 开源项目虽然提供了便利,但同时也伴随着复杂的配置和调试过程。 本文旨在为那些期待熟悉和采用写作模型的读者提供一份详细的指南,涵盖怎么样选择合适的模型、怎样训练一个写作模型以及怎样利用开源项目实施自主开发。

训练本身的写作模型

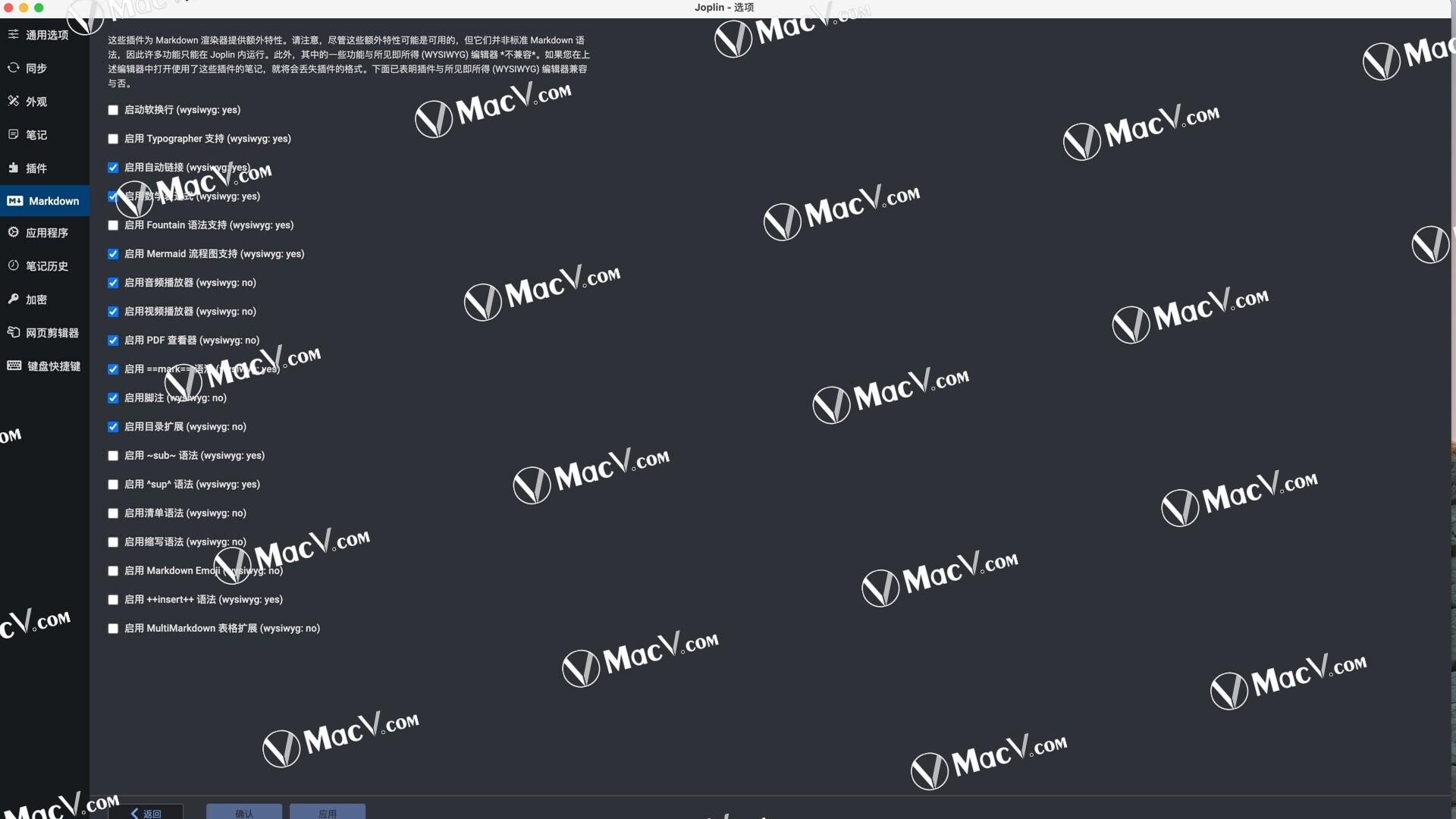

在选择训练写作模型之前首先需要明确训练目标。例如,假使你的目标是生成特定领域的专业文章,那么可以选择基于该领域的数据集实施训练。你需要准备一个合适的数据集。一般对于数据集越大越多样,训练出来的模型效果越好。常用的开源数据集涵盖Common Crawl、Wikipedia等。 选择一个适合的框架。目前主流的深度学习框架如TensorFlow、PyTorch等都提供了丰富的工具和库支持。以PyTorch为例,其提供的Transformers库可简化模型构建和训练过程。还需要考虑硬件资源。训练实习小编一般需要强大的GPU,要是预算有限,能够考虑采用云服务,如Google Colab或AWS等。 依据训练目标调整模型参数。这一步可能需要多次实验才能找到更优的参数组合。训练一个写作模型是一项复杂的工作,但只要掌握了正确的步骤和方法任何人都能完成这一任务。

怎么样训练一个写作模型

训练写作模型的过程大致能够分为以下几个步骤。首先是数据预解决。原始数据常常包含大量的噪声和无用信息,于是需要对其实行清洗和格式化。具体对于,可采用正则表达式或其他文本应对工具去除无关字符,并将文本分割成适当的大小。接着是特征提取。常用的特征提取方法包含词袋模型、TF-IDF等。这些方法可将文本转换为机器可理解的形式。然后是模型选择。目前流行的写作模型主要包含RNN(循环神经网络)、LSTM(长短期记忆网络)和Transformer等。其中,Transformer因其高效性和灵活性成为了当前的主流选择。接下来是模型训练。在训练期间需要不断调整学习率、批量大小等超参数,以达到性能。同时还能够利用部分技巧,如Dropout和Early Stopping来避免过拟合和增进模型泛化能力。最后是模型评估。评估指标往往包含准确率、召回率、F1分数等。通过这些步骤,你就能够训练出一个具备一定写作能力的实习小编。

写作模型开源

开源写作模型为开发者和研究者提供了一个广阔的平台。一方面,开源模型多数情况下经过大量测试和优化,具有较高的稳定性和可靠性。另一方面,开源社区的活跃度高,使用者能够轻松获取最新的研究成果和技术进展。目前GitHub上有很多知名的写作模型项目,如GPT-2、BERT等。这些项目不仅提供了源代码,还附带了详细的文档和教程,方便客户快速上手。对初学者对于,能够从阅读文档开始,逐步熟悉模型的基本原理和利用方法。而对有经验的开发者,则可通过参与社区讨论和贡献代码来进一步提升自身的技能。开源项目还鼓励使用者实行二次开发和创新,使写作模型的应用范围更加广泛。开源写作模型为推动人工智能技术的发展做出了关键贡献。

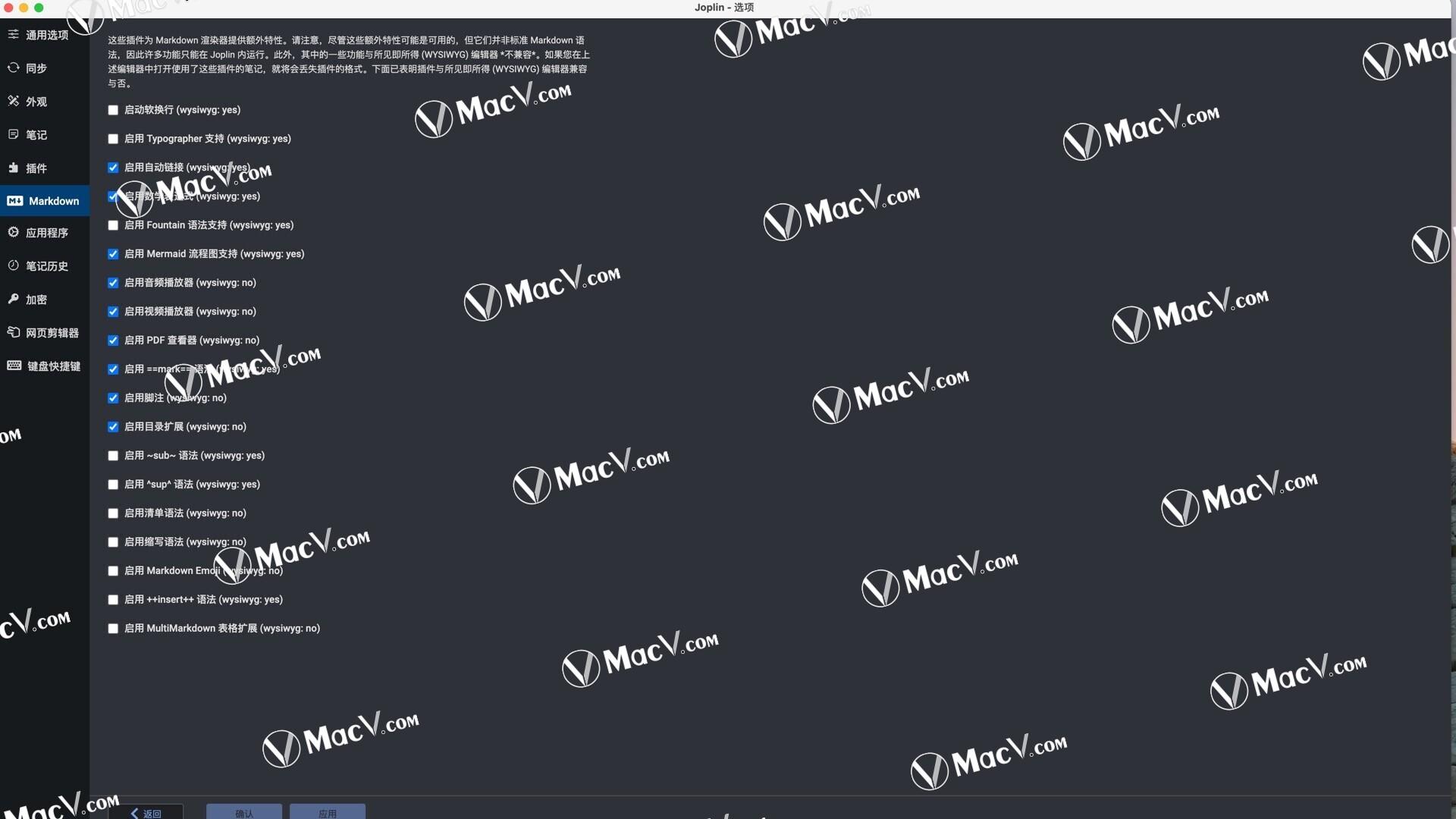

写作模型对比

写作模型种类繁多,各有优劣。例如,GPT-2以其强大的生成能力和多样性著称可生成连贯且富有创意的文本。相比之下BERT则更擅长理解和推理特别适用于问答系统和情感分析等任务。为了更好地理解这些模型的特点,可通过对比它们的架构、性能和应用场景来实行分析。从架构上看GPT-2采用了Transformer架构,而BERT则采用了双向Transformer。这类差异引起了它们在应对文本时的不同侧重点。从性能来看,GPT-2在生成任务上的表现更为出色而BERT在理解任务上的表现更胜一筹。 从应用场景来看,GPT-2更适合于创作类任务,如撰写文章和诗歌,而BERT则更适合于信息检索和分类任务。通过这些对比,可帮助客户更好地选择适合自身需求的模型。