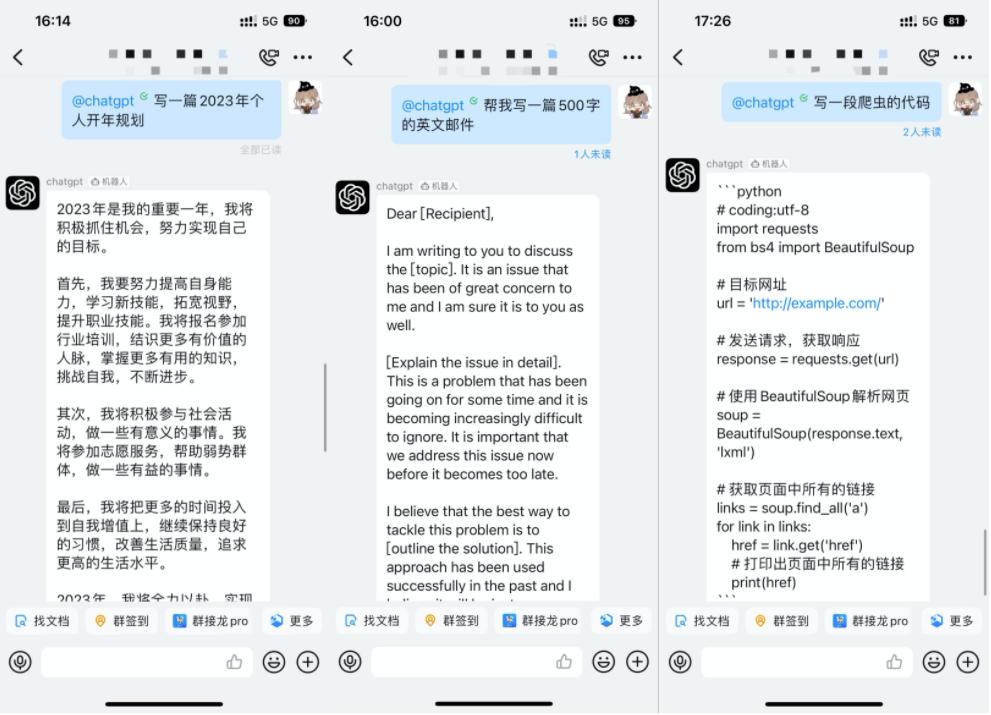

- 如何用ai写爬虫脚本

- 首页 > 2024ai知识专题 人气:10 日期:2025-01-17 22:32:49

文章正文

文章正文

1. 确定目标:确定你想要爬取的网站或数据源,明确爬取的目标数据类型如文本、图片、视频等。

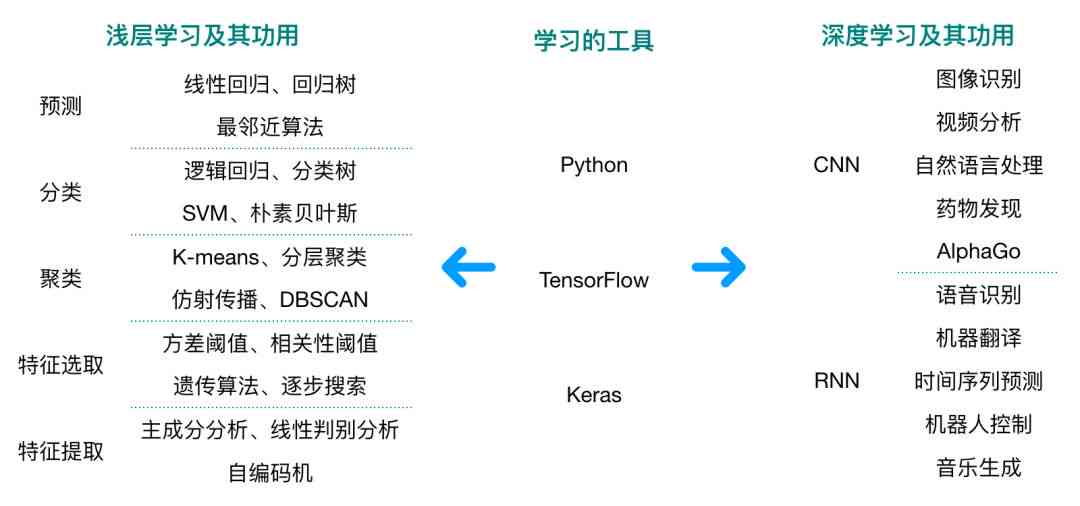

2. 选择合适的工具:依照需求,选择适合的工具,例如Python中的Scrapy框架,结合各种自然语言应对(NLP)库,如spaCy或NLTK。

3. 编写爬虫脚本:

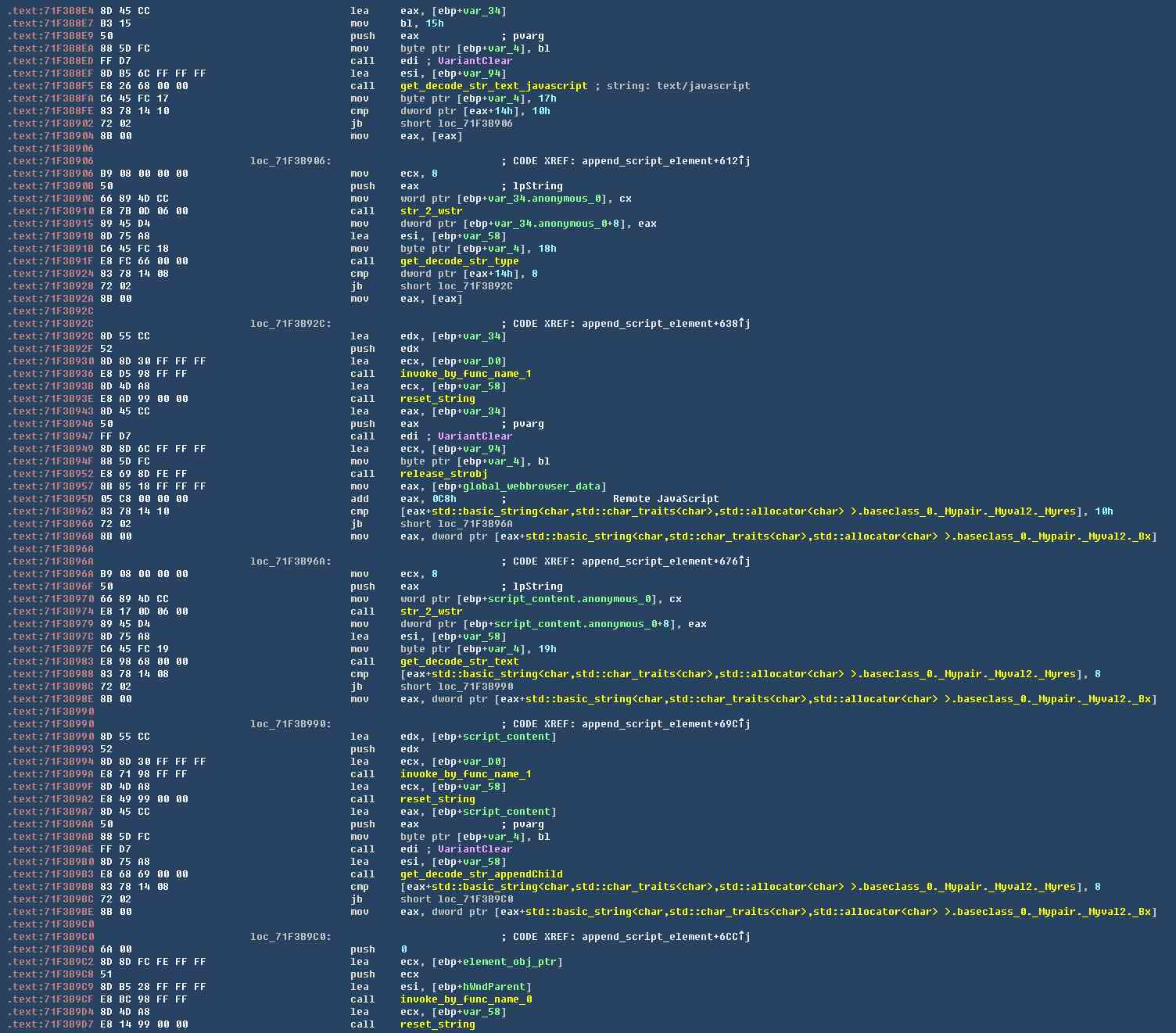

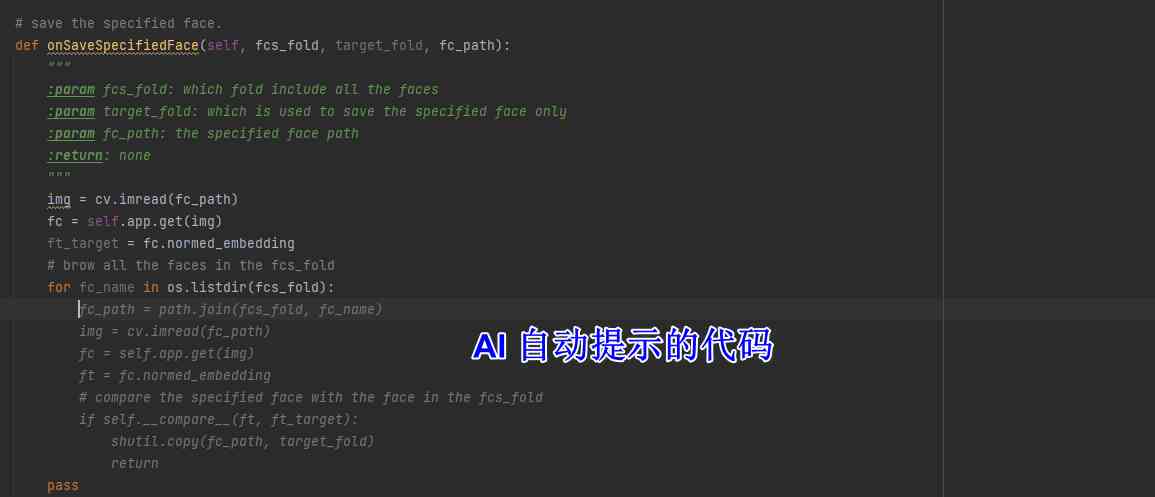

a. 导入所需库:导入Scrapy库以及其他可能需要的库如requests、BeautifulSoup、re等。

b. 创建爬虫类:创建一个继承自Scrapy的爬虫类,设置爬虫名称和起始URL。

c. 解析网页内容:利用BeautifulSoup或lxml库解析网页内容,提取所需数据。

d. 提取数据字段:按照目标数据类型,定义相应的数据字段,如标题、作者、发布日期等。

e. 数据存储:将提取的数据存储到文件、数据库或云服务器等。

4. 设置爬取策略:依据网站的反爬机制设置合适的请求头、代理IP、延迟等以升级爬取效率。

5. 运行爬虫:启动爬虫程序,监控运行情况,保障数据正确爬取。

6. 数据应对与分析:对爬取的数据实施清洗、去重、分析等操作,以满足实际需求。

7. 定期维护:随着目标网站结构的变化定期更新爬虫脚本,保证数据持续爬取。

全面解析AI脚本的使用方法及实例演示

内容简介 随着人工智能技术的发展脚本在各个领域的应用越来越广泛。从自动化数据应对到复杂系统模拟脚本不仅提升了工作效率,还大大减低了人工操作的错误率。本文旨在全面解析脚本的采用方法及其应用场景,通过实际案例展示怎样去编写和运行脚本。无论你是编程新手还是经验丰富的开发者,都可以从中获取实用的知识和技巧。咱们将探讨脚本的基本概念、编写原则,以及怎么样利用现有的平台和工具实现自动化任务。同时还会介绍部分常见的脚本插件及其采用方法并提供安装指南,帮助读者快速上手。 脚本怎么利用 脚本的利用主要分为两个方面:编写和实

深入解析:AI编程脚本撰写技巧与实现步骤

引言 随着人工智能技术的迅猛发展编程在各个领域的应用日益广泛。编程不仅仅是将算法堆砌在一起更是一种融合了机器学习、深度学习、自然语言解决等技术的复杂过程。脚本作为这一期间不可或缺的一部分不仅可以帮助开发者快速构建和测试模型还能升级开发效率和模型性能。编写高品质的脚本并不是一件容易的事情它需要开发者对编程语言、算法原理以及数据解决有深入的理解。 本文将从脚本的撰写技巧入手逐步深入到实现步骤详细探讨怎样编写出高效、可靠的脚本。通过分析脚本的基本构成、核心算法及其应用场景咱们将为读者提供一套全面的脚本开发指南。我们

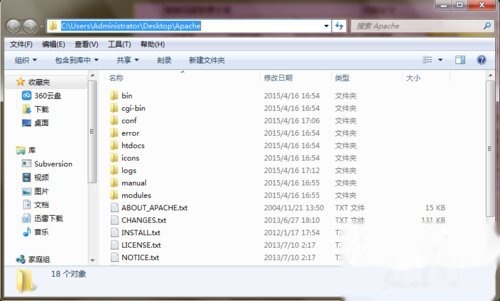

aiohttp爬虫get技巧:HTTP2、Apache与蚁群算法优化attrs在网页抓取中的应用

ohttp爬虫get技巧:HTTP2、Apache与蚁群算法优化attrs在网页抓取中的应用 1. 引言 在网络爬虫的开发中异步爬虫已经成为一种非常流行的技术。它可以充分利用计算机的资源,增进爬虫效率并且能够应对大量的运算请求。本文将详细介绍怎样去采用 `ohttp` 库构建高效的异步爬虫并探讨若干高级技巧和优化方法,包含 HTTP/2、Apache 服务器的配置以及蚁群算法在 attrs 网页抓取中的应用。 2. 安装 ohttp 咱们需要安装 `ohttp` 库,能够通过 pip 命令实施安装:

深入浅出:利用AI技术打造高效爬虫脚本全方位教程与实战指南

# 深入浅出:利用技术打造高效爬虫脚本全方位教程与实战指南 随着互联网技术的飞速发展网络爬虫成为了数据获取的要紧工具。传统的爬虫技术虽然可以实现自动化抓取,但在面对动态网站和复杂内容时往往力不从心。近年来技术的快速发展为网络爬虫带来了新的可能。本文将详细介绍怎么样利用技术打造高效爬虫脚本,并提供实战指南。 ## 一、爬虫的基本原理 1. 自动化访问与解析:爬虫通过自动化访问网页,利用解析库(如Scrapy)抓取网页内容。 2. 算法解决动态内容:结合人工智能算法,爬虫可以应对网站的动态变化,如JavaScr